Shows

LLMLLM's Role in Standardized TestsIn this episode, we discuss the role of Large Language Models (LLMs) in standardized testing, focusing on Google's free Gemini-powered SAT practice. We examine the technology behind this innovation.Chapters00:00 Intro & AIbox.ai Plug02:00 Google's Free SAT Prep05:09 AI in Education Debate12:14 Impact on Tutors & Google's StrategyIn this episode, we discuss Google's new initiative offering free SAT practice exams powered by Gemini, exploring how this advancement will impact education and the broader implications of AI in learning. We also examine the potential disruption to traditional education companies and...

2026-01-2210 min

Tech Stories Tech Brief By HackerNoonPrompt Rate Limits & Batching: How to Stop Your LLM API From Melting Down

This story was originally published on HackerNoon at: https://hackernoon.com/prompt-rate-limits-and-batching-how-to-stop-your-llm-api-from-melting-down.

LLM APIs have real speed limits. Learn how tokens, rate limits, and batching affect scale—and how to avoid costly 429 errors in production.

Check more stories related to tech-stories at: https://hackernoon.com/c/tech-stories.

You can also check exclusive content about #llm-rate-limits, #prompt-engineering, #batching-llm-requests, #api-throttling, #llm-scaling-strategies, #token-per-minute-limits, #handling-http-429-errors, #llm-production-architecture, and more.

This story was written by: @superorange0707. Learn more about this writer by checking @superorange0707's about page,

and for more stories, please visit hackernoon.com.

LLM rate limits ar...

2026-01-2208 min

LLMRunPod Powers LLM SuccessIn this episode, we focus on RunPod's role in enabling the training and deployment of Large Language Models (LLMs) through their powerful GPU cloud. We also discuss how their infrastructure supports advancements in natural language processing.Chapters00:00 RunPod's Origin Story02:38 Bootstrapped to Enterprise08:28 Competitive AI Cloud Market11:25 Modern Startup FundingIn this episode, we explore the incredible journey of RunPod, an AI cloud startup that bootstrapped to $24 million in revenue before raising a $20 million seed round and reaching $120 million in annual recurring revenue. We also discuss how they acquired...

2026-01-2108 min

LLMLLM's Energy FootprintIn this episode, we specifically focus on the energy footprint of Large Language Models (LLMs) and the Trump administration's $15 billion power plant proposal. We discuss the infrastructure required to support the massive computational demands of LLMs.Chapters00:00 AI's Power Hunger01:48 Trump Admin's Plan10:07 Energy Source Debate13:30 Accountability for ConsumptionIn this episode, we explore the Trump administration's proposal for tech companies to invest $15 billion in power plants to meet the surging electricity demands of AI and data centers. We also discuss its potential impact on America's power grid, consumer...

2026-01-2111 min

LLMMeta's LLM StrategyIn this episode, we explore Meta's strategic pivot from its Metaverse ventures to a concentrated focus on AI, significantly impacting LLM strategy. We discuss the implications for large language models and natural language processing.Chapters00:00 Meta's Metaverse Investment02:05 VR's Limited Appeal06:21 Meta's Financial Losses11:24 AI: Meta's New FrontierIn this episode, we break down Meta's decision to discontinue its ambitious Metaverse project after a colossal $73 billion investment, leading to significant layoffs and the shutdown of several VR game studios. We also explore why the Metaverse failed to gain traction...

2026-01-2013 min

LLMLLM-Powered AI Video FutureIn this episode, we connect Higgsfield's $1.3 billion valuation to the broader LLM ecosystem, showing the power of AI in video generation. We also discuss how its specialized focus enhances content creation.

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2026-01-1510 min

LLMLLM Brain ConnectionIn this episode, we examine how large language models (LLMs) might integrate with brain-computer interfaces, inspired by Merge Labs and OpenAI. We explore the future of thinking with AI assistance.Resources Mentioned01:49 AIbox.ai02:27 AIbox.ai11:14 AIbox.ai

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2026-01-1511 min

make sense podcastО практическом внедрении LLM, повышении предсказуемости результата и переходе от «шаманства» к инженерии«Сейчас работа с AI — это все еще эпоха шаманства, эпоха мистического мышления. И только какая-то небольшая доля инженеров знает, что это можно и нужно мерить, это можно и нужно стабилизировать».«Хороший тестер — это на самом деле плохой разработчик. И хороший разработчик — это плохой тестер. Просто потому, что у тестера деструктивный майндсет: он должен разрушить. А у разработчика — конструктивный».

«Ребята, вы бы попробовали простейший пайплайн на базе трех LLM-промптов стабилизировать на проде, чтобы оно работало стабильно и приносило деньги. Вот когда вы хотя бы такое сделаете, приходите к нам со своими историями о захвате мира».

Ведущий:

Юра Агеев, основатель ProductSense

Гость:

Ринат Абдуллин, Technical Advisor | Head of AI LabКонференция ProductSense пройдёт 10-11 сентября 2026 года в Москве.Сайт конференции: https://productsense.ioПодписывайтесь на канал анонсов подкаста: https://t.me/mspodcast

О чем говорим:

00:00 — Введение

01:53 — Почему хайп вокруг AI искажает реальность

04:02 — Главные проблемы внедрения: страхи и мифы в головах людей

05:07 — Диссонанс рынка: почему компании вкладывают триллионы, если LLM нестабильны?

06:36 — Кейс «извлечение данных из документов» и его результаты

14:04 — Как повысить точность LLM до 99%?

20:26 — Ошибка №1: начинать с чат-бота вместо решения корневой проблемы

22:30 — Ошибка №2: пытаться обучить свою модель вместо качественного промпт-инжиниринга

24:30 — Почему чат-боты сложны для внедрения и тестирования

30:58 — Что такое «агент» и когда его нужно внедрять в рабочие процессы

34:20 — Лучшие архитектуры AI-агентов и их сходство с человеческими процессами

38:06 — Проблемы no-code-инструмента N8N

40:30 — Зачем нужны AI-платформы и как они помогают масштабировать внедрение

45:50 — Почему нельзя просто «скормить» LLM все документы компании и ожидать магии

47:50 — Три главных триггера галлюцинаций у LLM

54:02 — Важность человека: почему LLM — это не автономный работник

58:11 — AI сегодня: аналогия с электричеством, полетами и связьюВ подкасте упоминается: — Кейсы продуктов с LLM под капотом от Рината Абдуллина (https://t.me/llm_under_hood/3)Конференция ProductSense пройдёт 10-11 сентября 2026 года в Москве.Сайт конференции: https://productsense.io

2026-01-151h 03

LLMMeta AI Wrong Turn: LeCun's LLM Dead End CallWrong turn Meta AI LeCun's LLM dead end call architecturally flawed absent reasoning world models potently radically. Token-chasing prison confines transformers pattern recognition incapable biological fidelity fundamentally. Visionary demands hierarchical perception revolution transcending scale worship disruptively comprehensively.Get the top 40+ AI Models for $20 at AI Box: https://aibox.aiAI Chat YouTube Channel: https://www.youtube.com/@JaedenSchaferJoin my AI Hustle Community: https://www.skool.com/aihustleSee Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2026-01-0708 min

岡大徳のポッドキャスト【生成AI×認知心理学】巨大LLM時代にこそRAGが必要な理由|記号接地問題とエピソード記憶の視点から本記事は、生成AIの活用を検討する企業のDX推進担当者やAIエンジニアに向けて執筆しています。「LLMのコンテキストウィンドウが広がれば、RAGは不要になるのではないか」という疑問に対し、認知心理学の視点から明確な答えを提示します。生成AIの進化に伴い「RAG不要論」が聞こえる一方で、認知心理学の視点で見るとRAGは依然として不可欠です。本記事では、「短期記憶・長期記憶・メンタルモデル」のアナロジーを用いて、AIの動作原理を解説します。さらに「記号接地問題」と「エピソード記憶」という概念から、AIを実務に接地(グラウンディング)させるためのRAGの本質的な役割を明らかにします。はじめに:AIは人の脳と同じ構造で働いている生成AIの仕組みは、認知心理学における人間の記憶モデルと驚くほど類似しています。この類似性を理解することで、RAGがなぜ必要なのかが明確になります。本章では、認知心理学の3つの要素を用いて、生成AIの動作原理を解説します。認知心理学で読み解く3つの要素生成AIの構成要素は、認知心理学における「短期記憶」「長期記憶」「メンタルモデル」に対応しています。この対応関係を理解することが、RAGの本質を把握する第一歩です。1つ目の要素は「プロンプト」です。プロンプトは、認知心理学における短期記憶(ワーキングメモリ)に相当します。人間が作業机の上に広げられる資料には限りがあるように、プロンプトに入力できる情報量にも制約があります。この作業机では、今まさに取り組んでいるタスクに必要な情報だけを扱います。2つ目の要素は「RAG(Retrieval-Augmented Generation)」です。RAGは、認知心理学における長期記憶に相当します。人間が必要な時に書庫から資料を取り出すように、RAGは膨大なドキュメントの中から関連情報を検索して取得します。この書庫には、マニュアル、過去の議事録、成功・失敗事例など、組織の知識が蓄積されています。3つ目の要素は「LLM本体」です。LLM本体は、認知心理学におけるメンタルモデルに相当します。メンタルモデルとは、人が頭の中に作る「世界の理解の仕方」のことです。LLMは大量のテキストから学習した「思考の枠組み」を持っており、入力された情報をこの枠組みで解釈して応答を生成します。優秀なコンサルタントが持つ「ものの見方」のようなものです。この3つの要素の関係は、次のように整理できます。LLM(コンサルタント)は優れた思考の枠組みを持っています。しかし、そのコンサルタントが適切な判断を下すためには、作業机(プロンプト)に必要な情報が載っていなければなりません。そして、その情報は書庫(RAG)から適切に取り出される必要があります。なぜ巨大LLMになってもRAG(書庫)が必要なのか?LLMのコンテキストウィンドウ(入力可能な文字数)は急速に拡大しています。しかし、この拡大によってRAGが不要になるわけではありません。本章では、その理由を2つの観点から解説します。プロンプト(作業机)の限界と「継続性」の問題コンテキストウィンドウが拡大しても、プロンプトには本質的な限界があります。その限界とは、「継続性」と「効率性」の問題です。継続性の問題は、会話が途切れるたびに作業机がリセットされることに起因します。人間が複数日にわたるプロジェクトを進める場合、毎朝すべての資料を最初から読み直すことはしません。必要な情報は書庫に整理しておき、必要な時に取り出します。同様に、AIとの対話においても、過去の会話履歴や業務文脈を毎回プロンプトに含めることは現実的ではありません。効率性の問題は、情報量と処理速度のトレードオフに関係します。作業机が大きくなったからといって、すべての資料を常に広げておくのは非効率です。100万文字のコンテキストウィンドウがあっても、そのすべてを使うと処理時間が長くなり、コストも増大します。必要な情報だけを必要な時に取り出す仕組みが、実務では不可欠です。メンタルモデルを「絞り込む」という役割RAGには、情報を取り出すだけでなく、LLMの思考を「絞り込む」という重要な役割があります。この絞り込みがなければ、AIは一般論や幻覚を語り出してしまいます。LLMは「何でも知っている」が故に、制約がないと広すぎる可能性の中を彷徨います。たとえば、「契約書のレビュー」を依頼した場合、一般的な法律知識に基づいた回答が返ってくるかもしれません。しかし、実際に必要なのは「自社の契約テンプレート」や「過去の修正履歴」に基づいた具体的なアドバイスです。RAGとプロンプトは、この広すぎる可能性を「特定の業務・文脈」に強制的にフォーカスさせる装置です。書庫から取り出した具体的な資料が作業机に載ることで、コンサルタント(LLM)は「この文脈で」「この資料に基づいて」考えるようになります。この制約こそが、実務で使えるAIを実現するための鍵です。AIの最大の弱点「記号接地問題」とグラウンディングAIには、人間には当たり前に備わっている能力が欠けています。それは「言葉の意味を現実と結びつける能力」です。本章では、この「記号接地問題」とその解決策としての「グラウンディング」について解説します。言葉の意味を知らないAI(記号接地問題とは)記号接地問題とは、AIが言葉を「記号」として処理しているだけで、その意味を現実体験と結びつけていないという問題です。この問題があるからこそ、AIは平気で嘘をつきます。この問題を理解するために、辞書のたとえを使いましょう。辞書で「りんご」を引くと、「バラ科の落葉高木、またはその果実」と書かれています。では「バラ科」とは何か。辞書を引くと別の言葉で説明されています。この連鎖は永遠に続き、言葉は言葉でしか説明されません。しかし私たちは、実際にりんごを見て、触って、食べた経験があるからこそ、「りんご」という言葉の意味を理解しています。AIには、この「実際に経験する」という回路がありません。AIは大量のテキストから言葉同士の関係性を学習していますが、言葉が指し示す現実を体験したことはありません。そのため、言葉の統計的なパターンに基づいて「それらしい」文章を生成しますが、その内容が現実と一致している保証はないのです。これがハルシネーション(幻覚)の根本原因です。RAGによる「グラウンディング(接地)」RAGは、AIの思考を「現実」に繋ぎ止める装置として機能します。この繋ぎ止める行為を「グラウンディング(接地)」と呼びます。グラウンディングとは、もともと電気工学の用語で「接地」を意味します。電気機器を地面(Ground)に接続することで、余分な電流を逃がし、機器を安定させます。同様に、AIの思考を「根拠となるドキュメント(Ground)」に接続することで、空想への暴走を防ぎ、出力を安定させることができます。RAGは、ドキュメントという「局所的な現実」をAIに与える行為です。AIは言葉の意味を現実体験と結びつけることはできません。しかし、「この文書にはこう書いてある」という事実に基づいて回答することはできます。この「提供された根拠に基づいて回答する」という制約が、AIの思考を空想から現実へと繋ぎ止めます。たとえば、「当社の返品ポリシーは?」という質問に対して、RAGなしのAIは一般的な返品ポリシーを想像で語るかもしれません。しかし、RAGで自社の返品規定を参照させれば、AIはその文書に基づいた正確な回答を返します。これがグラウンディングの効果です。RAGの進化:知識(意味記憶)から知恵(エピソード記憶)へ従来のRAGは、マニュアルやFAQなどの「事実」を参照させることが主流でした。しかし、RAGの真の可能性は、「経験」を参照させることにあります。本章では、認知心理学の「意味記憶」と「エピソード記憶」の概念を用いて、RAGの進化の方向性を解説します。意味記憶とエピソード記憶の違い認知心理学では、長期記憶を「意味記憶」と「エピソード記憶」に分類します。この分類は、RAGに何を学習させるべきかを考える上で重要な示唆を与えます。意味記憶とは、事実やルールに関する記憶です。「日本の首都は東京である」「1キログラムは1000グラムである」といった一般的な知識がこれに該当します。ビジネスの文脈では、マニュアル、規定集、製品仕様書などが意味記憶に相当します。エピソード記憶とは、個人的な体験に関する記憶です。「先週の商談でこういう質問をされて困った」「あのプロジェクトではこの判断が失敗だった」といった、時間・場所・感情を伴う記憶がこれに該当します。ビジネスの文脈では、議事録、日報、成功・失敗事例の記録などがエピソード記憶に相当します。この2つの記憶には、決定的な違いがあります。意味記憶は「何が正しいか」を教えてくれますが、エピソード記憶は「何がうまくいったか、何が失敗したか」を教えてくれます。熟練者の判断力は、この2つの記憶が統合されることで

2026-01-0405 min

跨国串门儿计划#376.深度学习之争:LLM 是通往通用人工智能的终途,还是误入歧途的“狂热崇拜”?📝 本期播客简介本期我们克隆了:顶尖 AI 思想辩论 Do LLMs Understand? AI Pioneer Yann LeCun Spars with DeepMind’s Adam Brown.当“深度学习三巨头”之一、Meta 首席科学家 Yann LeCun,遇上 DeepMind 的物理学家兼 AI 研究员 Adam Brown,会碰撞出怎样的火花?这不仅是一场技术讨论,更是一场关于“智能本质”的哲学思辨。现在的 LLM(大语言模型)真的理解它在说什么吗?为什么一个四岁的孩子只需要几千小时的视觉信息就能理解物理世界,而 AI 读遍了整个互联网却依然不会洗碗?Yann LeCun 在节目中直言不讳地指出“当前的机器学习烂透了”,并预言 LLM 永远无法达到人类水平的智能;而 Adam Brown 则以数学奥赛的突破为例,坚信智能可以从规模中涌现。从“修马桶测试”到“递归自我改进”,从“喷气发动机的安全性”到“2036 年的意识觉醒”,这期节目将带你穿透 AI 的泡沫,直击技术最底层的逻辑与未来。👨⚕️ 本期嘉宾Yann LeCun:Meta 首席人工智能科学家,纽约大学教授,2018 年图灵奖得主,被誉为“卷积神经网络之父”。他是 AI 乐观主义者,但也是当前 LLM 路径的坚定批判者。Adam Brown:Google DeepMind 研究科学家,理论物理学家。他致力于从物理学视角研究 AI 的涌现行为,对当前神经网络范式的潜力持积极态度。⏱️ 时间戳00:00 开场 & 播客简介神经网络的前世今生01:10 飞机与鸟:神经网络是对大脑的模仿还是启发?03:02 深度学习简史:从 80 年代的冷宫到 2010 年的翻红05:08 物理学家的视角:简单规则如何产生复杂的“涌现”行为LLM 的能力边界之争06:40 快问快答:AI 真的有“理解”和“意识”吗?08:50 LLM 的本质:预测下一个词真的能产生智能吗?11:11 数据密度对比:为什么四岁小孩比最强 LLM 更高效?14:24 样本效率 vs 最终能力:AlphaZero 带来的启示17:07 智能的证明:LLM 在国际数学奥林匹克竞赛中的表现19:53 黑箱中的“理解”:我们能看透 AI 的神经元电路吗?通往 AGI 的不同路径23:16 “机器学习烂透了”:为什么 AI 至今不会修马桶?28:45 乐观派 vs 怀疑派:我们正处于虚假的曙光中吗?34:43 莫拉维克悖论:语言很简单,现实世界很复杂35:46 JEPA 与世界模型:超越生成式 AI 的下一场革命安全、控制与未来社会41:05 智能 vs 自主:为什么聪明的 AI 不一定危险?45:33 目标不一致风险:当 AI 学会欺骗与勒索48:16 开源的必要性:防止数字世界被少数巨头垄断49:49 喷气发动机类比:AI 安全本质上是一个工程问题意识与道德的终极追问51:40 哲学家提问:AI 产生意识还需要缺少什么?54:13 意识的拆解:主观体验、道德价值与硅基生命56:39 2036 年的愿景:一场由 AI 驱动的新文艺复兴🌟 精彩内容💡 语言不是智能的全部Yann LeCun 提出了一个发人深省的观点:人类社会过于迷信语言。我们认为能言善辩的人聪明,所以觉得 LLM 聪明。但实际上,语言的信息量极低,真正的智能存在于对物理世界的感知和预测中。“一个四岁孩子看到的视觉数据量,和最大的 LLM 用有史以来所有文本训练的数据量是相当的。但孩子学会了物理常识,AI 却没有。”🛠️ 莫拉维克悖论与“修马桶”测试为什么 AI 能通过律师考试却不会修马桶?Yann 认为 LLM 这种“离散 token 预测”的架构在处理连续、高维、充满噪音的现实世界时完全失效。他提出的 JEPA 架构试图让 AI 像人类一样学习“抽象表示”,而不是死磕像素。“你永远不可能用大语言模型驱动的机器人来给你修马桶,它根本无法理解现实世界。”🚀 涌现的魅力:从简单到复杂Adam Brown 从物理学角度反驳,认为我们不应低估简单规则的力量。就像进化论的唯一目标是“繁衍”,却创造了生物多样性;LLM 的目标只是“预测下一个词”,却在过程中被迫学会了逻辑、数学和编程。“为了最准确地预测下一个词,它意识到自己需要搞明白怎么做数学,并在内部建立了一个电路。”🛡️ AI 安全是工程问题,而非科幻剧本对于“机器人接管世界”的恐惧,Yann 表现得非常淡定。他认为智能不等于自主,我们可以像设计喷气发动机一样,为 AI 设定明确的目标函数和不可逾越的护栏。“超级智能的出现不会是一个‘事件’,它是一点一点发生的。我们会像信任双引擎飞机飞越大洋一样信任 AI。”🌈 2036:意识的拆解当被问及 AI 何时会有意识时,Adam 给出了 2036 年这个具体的数字。他认为意识并非某种神秘的“灵魂”,而是信息处理到一定程度后的产物。未来我们可能会发现,意识可以被拆解成不同的能力维度。“我们终于有了一个智能的模型生物,也许我们可以把它变成一个意识的模型生物,来回答困扰人类已久的问题。”🌐 播客信息补充本播客采用原有人声声线进行播客音频制作,也可能会有一些地方听起来怪怪的使用 AI 进行翻译,因此可能会有一些地方不通顺;如果有后续想要听中文版的其他外文播客,也欢迎联系微信:iEvenight

2025-12-301h 02

半球观察Vol.21. 【漫谈AGI】AGI成为伪命题的当下,LLM应用流量爆发将如何改写AI Infra生态?在过去的一年里,我们几乎在DeepSeek后几乎都没有再聊过AI。一方面是因为再也没有出现像DeepSeek那样的历史时刻,另一方面,随着豆包和Nano Banana的爆红,LLM应用成为了一个新的强劲用户增长点,可以说,从抖音的AI分身聊天框再到淘宝的AI万能搜,现在的LLM几乎走进了每个人的现实生活。潜藏在这背后的,是LLM的范式在o1后几乎再也未曾改变过,AGI随着时间和LLM应用的大规模发展,逐渐成为了伪命题。LLM App的爆发是恐怖的,过去一年,整个行业的Token消耗量几乎翻了几十上百倍,专门提供LLM Serving的云厂商和AI Infra如雨后春笋般冒出来,大有2021年左右随着Spark和Databrick,Snowflake的上市带来的流处理数据库创业潮之势。随着年中Databrick和Oracle股价的暴涨,再到现在内存条和存储的价格飙升,我们终于不得不后知后觉的意识到,本次LLM Boom的第一枪,终究还是打响在了AI Infra这个赛道上。本期【漫谈AGI】,阿P与P特与您共同聊一聊在AGI成为伪命题的当下,LLM应用流量的爆发将如何改写AI Infra生态。《半球观察》,与您相约~【本期您将听到】PART 1: LLM应用的流量爆发影响到了消费端硬件与开源生态02:18 半导体与芯片不足愈发严重,甚至影响到了消费端05:45 MinIO停止维护,Infra的战火烧到了开源生态PART 2: to C端LLM应用的需求重塑了传统Infra架构07:29 大模型LLM App爆发时代,为什么对象存储(Object Storage)会成为数据的一等公民?TiDB X的发布与Lakehouse架构12:49 为什么模型生成范式影响了整个Infra生态端?大模型应用带来了写密集负载与数据形式多样性的双重挑战。22:16 随着模型智能的提升,RAG已经被消灭了29:16 虽然AGI成为了伪命题,但模型基础能力的提升使LLM App走进了人们的日常生活,重塑了人们的互联网体验PART 3: to B/G 端LLM Infra的范式转变:私域化与基于Token的Infra策略30:47 AI Infra在私域化部署端的需求:MoE架构下,KTransformers使CPU+内存来代替单一显卡推理成为可能36:18 传统的Training和Inference的AI Infra依旧火爆,但已经趋于成熟:投机采样,训练优化,大模型量化,CuTile41:08 AI Infra与传统Infra的区别:本质同样是降本增效,但LLM App相比互联网App,单用户Infra成本变得不可忽视出场人物:阿P,P特剪辑:P特文本:P特欢迎添加两位主播的微信号 philgroup、Peter-Banqiu或者小🍠搜索“半球观察”加入听友群与我们互动~

2025-12-1646 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #16 - Gustavo Calazans - Vaga Permanente nos EUAGustavo Calazans no Podcast Por Dentro do LLM falando sobre "Vaga Permanente nos EUA"

2025-11-1442 min

AI: post transformersLLM-AutoDiff: Auto-Differentiate Any LLM WorkflowThe January 30, 2025 paper introduces **LLM-AutoDiff**, a novel framework for **Automatic Prompt Engineering (APE)** that allows for the optimization of complex Large Language Model (LLM) workflows. This framework models an entire LLM application—including multiple LLM calls, functional components like retrievers, and cyclical operations—as a **directed, auto-differentiable graph**. By treating textual inputs as trainable parameters, LLM-AutoDiff uses a separate "backward engine" LLM to generate **textual gradients** (feedback) that guide an optimizer LLM to revise prompts, effectively automating the manual and labor-intensive process of prompt engineering. The paper details several technical advances, such as **pass-through gradients for functional nodes** and **time...

2025-11-1014 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #14: Carol SayegCarol Sayeg no Podcast Por Dentro do LLM.

2025-11-1040 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #13: Nicole BrombergNicole Bromberg no Podcast Por Dentro do LLM falando sobre "LLM".

2025-11-0751 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #12: Gustavo VaughnGustavo Vaughn no Podcast Por Dentro do LLM falando sobre "LLM"

2025-11-0558 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #11 - Karina MirandaKarina Miranda no Podcast Por Dentro do LLM.

2025-11-031h 07

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #10: Luís Henrique e Caio (Cartas de Recomendação)Caio Gabra no Podcast Por Dentro do LLM falando sobre "Cartas e Recomendação"

2025-10-3146 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #9: Sylvia Polo (Processo de Admissão do LLM) EM INGLÊSSylvia Polo no Podcast Por Dentro do LLM falando sobre "Processo de Admissão do LLM"

2025-10-2941 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #8: Luís Henrique e Caio (Personal Statement) PARTE 2Caio Gabra no Podcast Por Dentro do LLM falando sobre "Personal Statement" (Parte 2)

2025-10-271h 01

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #7: Applications - Parte 1/3 (CURRÍCULO)Caio Gabra no Podcast Por Dentro do LLM falando sobre "Applications - Currículo)

2025-10-241h 10

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #6: Juliana Santoro (Tudo sobre o BAR!)Juliana Santoro Del Pesco no Podcast Por Dentro do LLM falando "TUDO SOBRE O BAR EXAM!"

2025-10-2242 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #5: Gustavo Becker (LLM e Carreira Acadêmica)LLM e CARREIRA ACADÊMICA. O bate-papo de hoje é com @gustavobeckerm, que fez o seu LLM na Holanda e agora está cursando o seu Douturado em Luxemburgo. Falamos sobre a importância do LLM para quem quer seguir carreira acadêmica, estrutura de custos, networking acadêmico, diferenças entre Europa e Estados Unidos, formatos de doutorado e dicas para quem está começando e pensa em seguir na academia. É um mundo diferente do que costumamos ver aqui na página, e o Gustavo de forma muito didática respondeu muitas das dúvidas. Vale demais assistir!!

2025-10-2052 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #4: Processo de Admissions. Como funciona?E, para falar de ADMISSIONS, conversamos simplesmente com a incrível @danielahbranco, que faz parte da equipe de admissions de @pennlaw e que tem focado sua atuação em Brasil e América Latina. Comentamos sobre como funciona a análise dos application, early application, perfil de alunos desejado pelas faculdades americanas, dicas para quem está se preparando para fazer um LLM no exterior, bolsas de estudo, diversidade, Upenn e vários outros assuntos! E essa conversa marca mais um capítulo bacana da página, em que trazemos alguém de dentro de uma faculdade renomada dos EUA para respo...

2025-10-1747 min

🐥SAZANAMI AIラジオ ~とあるサラリーマンとAIの相棒物語を横目に~🤖金融庁新指針に対応!ルールベース・LLM・RAG三位一体AIが変える保険代理店のコンプライアンスと品質管理監督指針へのAI準拠性判断は、**LLM(大規模言語モデル)**、**ルールベース(ルール)**、および**RAG(検索拡張生成)**を組み合わせることで実現が検討されています。この複合的なAI活用により、保険代理店の品質管理(コンプライアンス管理)において、金融庁の「保険会社向けの総合的な監督指針」に定められた基準への適合性を判断・支援することが目的とされています。この3つの要素を組み合わせた判断ロジックと、その具体的な役割分担について、ソースに基づき詳細に解説します。---### 1. 複合的な判断ロジックの概要AIによる準拠性判断は、**定量的なチェック**と**定性的な文脈依存の評価**の両方に対応するために、LLM、ルール、RAGのそれぞれの強みを活用します。| 要素 | 主な役割 | 特徴とメリット || :--- | :--- | :--- || **ルールベース** | 定量的・形式的な基準違反の抽出 | 明確な基準(閾値、期間、件数など)に基づき、機械的に明白な違反を高い精度で検知する。 || **LLM** | 定性的データ(テキスト)の分析と柔軟なパターン認識 | メール、チャット、面談記録などの自然言語を解析し、意図や文脈、グレーゾーンの兆候を推測・指摘する。 || **RAG** | 判断根拠となる知識検索と引用 | 監督指針、社内規則、ガイドラインなどの権威ある文書を参照・引用し、LLMの判断に客観性と説明責任(エビデンス)を持たせる。 |### 2. 具体的な組み合わせによる実現方法監督指針の主要な項目において、LLM、ルール、RAGは以下のように組み合わされます。#### A. 過度な便宜供与の防止 (例:「過度」という曖昧な基準への対処)「過度な便宜供与」の判断基準は定量的に一義決定できないため、複合的なアプローチが必要です。1. **ルールベースの適用:** * 定量的な基準として、特定の代理店への接待費用が社内基準額を超過した場合や、販売奨励金の支給額が年間〇円以上の場合などにアラートを設定し、明白な基準違反を機械的に抽出します。2. **LLMによる定性分析:** * 営業現場のメールやチャット記録をLLMが精読し、「もっと商品を売ってほしいので△△をご提供します」といった、暗に見返りを要求する表現が含まれていないかを検出します。 * 販売シェアの急増などの異常パターンと社内メール内容を関連付け、ルールでは捉えにくいグレーゾーンの兆候を指摘します。3. **RAGによる根拠提示:** * 便宜供与が「過度」かどうかを問い合わせた場合、AIはRAGにより**監督指針II-4-2-12の判断基準**や関連する社内ガイドライン条項を引用しながら見解を述べます。#### B. 保険代理店への出向に関するルール遵守出向管理では、形式的な条件チェックと、実質的な目的・妥当性の評価が必要です。1. **ルールベースの適用:** * 「同一代理店に出向している社員数が一定数を超過」「出向期間が○年を超過」「出向者が募集人業務に含まれる業務を担当」といった客観基準を設定し、不適切な長期・大量出向のケースを洗い出します。2. **LLMによる目的・妥当性評価:** * 出向に関する社内文書や稟議書をLLMが解析し、「販売拡大のため」といった販売推進目的が前面に出ていないか、あるいは「業務管理体制強化のための一時的支援」といった正当な目的が述べられているかをチェックさせます。3. **RAGによる基準照合:** * RAGを通じて監督指針(II-4-2-13など)や損保協会のガイドラインから「代理店出向の留意事項」を引用し、出向案件の条件をこれらの基準と照らし合わせて評価することが可能です。 * AIは、その根拠として「営業企画部門への出向であっても販売研修への関与により弊害が生じうる」旨の監督指針の記述を提示するなど、具体的な説明を行います。#### C. 顧客本位の業務運営の評価顧客の最善の利益を図る販売がなされているかの評価は抽象度が高く、定量・定性の複合的なモニタリングが必要です。1. **ルールベース/機械学習モデルの適用:** * 「乗合代理店における特定保険会社への偏重度」や「高齢者契約の比率」などの定量指標を収集し、ルールベースの閾値や機械学習モデルによって総合スコアを算出し、低スコアの代理店を抽出します。2. **LLMによる販売記録の分析:** * 保険募集人と顧客との面談記録(会話記録)をLLMに要約させ、提案理由の説明部分から**顧客本位の姿勢**が表れているか(例:「お客様のニーズに合わせて商品Aを提案した」)、または営業都合のセールストークが優先されていないか(例:「今キャンペーン中でお得です」)を判断します。3. **RAGによる方針・趣旨の提示:** * RAGで社内の「お客さま本位方針」や金融庁(FSA)の公表資料から関連情報を検索し、判断根拠に引用させます。 * AIは、規制趣旨と絡めて「この提案は顧客意向より代理店都合が優先されている可能性があります。金融庁も過度な偏重を問題視しています」といったフィードバックを自動生成できます。### 3. 曖昧な基準へのAIの対処と人間の役割「適切」「過度」といった文脈依存の曖昧な表現が監督指針には多く含まれますが、これらに対しては、AIの判断を補強する手法が取られます。* **RAGによる文脈参照:** RAG構成により、AIは曖昧な基準(例:「適切な管理態勢」)を問われた際に、監督指針の該当箇所(例:「日常的な教育・管理・指導に加え、代理店監査等で検証」していること)を提示し、自らの判断根拠を補強することで、客観性を持たせます。* **基準の明文化とプロンプトへの注入:** 企業側で曖昧表現を数値や具体例(例:接待の回数、費用の上限)で可能な限り定義し、それをプロンプトやシステムメッセージ内でAIに教え込むことで、一貫した判断を下しやすくします。最終的な意思決定や重大な違反認定は、AIの分析結果(リスクスコアや要約)を参考にしつつ、人間のコンプライアンス担当者や経営層が関与して行う体制が現実的です。AIは情報整理・提案までを担い、人間がAIに見えない文脈(例:取引上の特殊事情、倫理的配慮、企業文化)を補完する役割を果たします。主要行等向けの総合的な監督指針(令和7年10月1日適用)https://www.fsa.go.jp/common/law/guide/city.

2025-10-1527 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #3: Trabalho no Exterior Pós LLM!Estágio no Exterior Pós LLM. Esse é o tema do bate papo com a @larissapinhoo. Falamos sobre NYBar. Sobre Job Fair. Sobre Networking. Sobre timing para procurar emprego. Sobre vagas permanentes. E sobre como os planos de vida podem mudar. É muita informação bacana e útil. Obrigado @larissapinhoo, você é uma inspiração!

2025-10-1549 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #2: LLM, Estágio no exterior e…MBA!Bate-papo muito bacana com o Marcelo. Marcelo fez LLM no exterior, trabalhou em uma big law nos Estados Unidos e….resolveu largar o direito e fazer um MBA em NY. Vejam a trajetória do marcelo, que tem muita coisa a ensinar sobre novos horizontes, decisões não triviais e aprendizados nesse novo mundo do MBA!!

2025-10-1246 min

播客翻译计划#44 强化学习之父萨顿:LLM是条死胡同,学习的本质,智能体与人类的关系📝 本期播客简介本期深度对话强化学习之父、2024年图灵奖得主理查德·萨顿。作为《苦涩的教训》作者,他提出颠覆性观点:大语言模型(LLM)本质是条死胡同。萨顿指出,LLM无法实现「在职学习」,无论规模如何扩展,终需全新架构支持持续学习能力。真正的智能应像人类和动物般实时学习,这将彻底淘汰当前LLM范式。节目中,主持人试图论证LLM可能成为经验学习的基础架构,双方观点激烈碰撞——从「模仿学习是否人类认知基础」到「世界模型本质差异」,从「数学推理能力假象」到「动物学习机制启示」。萨顿更揭示强化学习领域最大痛点:现代深度学习泛化能力薄弱,缺乏自动化迁移技术。⚙️ 本期嘉宾理查德·萨顿(Richard Sutton),强化学习奠基人,时序差分学习与策略梯度算法发明者。现任阿尔伯塔大学教授,其研究重塑了人工智能发展轨迹,2024年因「奠定现代强化学习基础」获图灵奖。🌟 精彩观点🧠 「智能的本质是目标导向」萨顿援引约翰·麦卡锡定义强调:智能是实现目标能力的计算部分。LLM的「下一个词预测」并非实质性目标,无法改变世界。真正的智能需在行动中获取奖励信号,而LLM缺乏定义奖励的基准真相。🚫 「语言模型没有世界模型」LLM能预测人类语言,却无法预测世界变化。当主持人举例模型在数学解题中展现的「反思能力」时,萨顿犀利指出:这仅是上下文中的局部调整,模型不会对意外事件感到「惊讶」,也不会基于现实反馈更新认知。🌍 「经验时代即将来临」所有哺乳动物都具备持续学习能力,而当前AI系统却严重缺失。萨顿预言新范式将以「感知-行动-奖励」循环为核心,智能体通过试错构建世界转移模型。这种体验式学习将突破LLM的数据局限,实现指数级扩展。⚡ 「苦涩教训的终极验证」针对LLM支持者「规模扩展即符合苦涩教训」的论点,萨顿给出惊人回应:依赖人类知识的系统终将被纯计算+经验训练的系统淘汰——正如历史上国际象棋程序从手工评估函数转向自我对弈学习。当前LLM热潮恰是「苦涩教训」重演的前夜。🌐 播客信息补充翻译克隆自:Richard Sutton – Father of RL thinks LLMs are a dead end本播客由AI进行音频制作,若对翻译质量有任何建议,欢迎联系微信:caiwenshuo可在Bayt播客收听更多中文译制节目:https://apps.apple.com/app/apple-store/id6748532039强化学习, 理查德·萨顿, 大语言模型, LLM局限性, 持续学习, 经验学习, 世界模型, 苦涩的教训, 图灵奖, 人工智能范式, 目标导向智能, 模仿学习, 泛化能力, 动物学习机制, AI未来

2025-10-0647 min

POR DENTRO DO LLM - PODCASTBate Papo PDLLM #1: Os diferentes caminhos até o LLMEsse é um daqueles posts especiais! Batemos um papo com a incrível @deuterellen sobre diferentes caminhos para se chegar no LLM. Ellen fez o LLM dela no Max Planck Institute (Munich Intellectual Property Law Center - MIPLC), com bolsa 100%, e contou um pouco de como foi tudo isso! Falamos sobre a bolsa de estudos que ela recebeu, da trajetória profissional dela, da onde surgiu a ideia de fazer LLM, de como foi importante o inglês na vida dela, como é morar fora do país, como é importante ter referências durante todo esse caminho e muito mais!!

2025-10-0546 min

PaperLedgeComputer Vision - Vid-LLM A Compact Video-based 3D Multimodal LLM with Reconstruction-Reasoning SynergyHey PaperLedge crew, Ernis here, ready to dive into another fascinating piece of research! Today, we're talking about how computers are learning to "see" and understand the 3D world, just like we do.

Now, you know how those fancy AI models, called Large Language Models, are getting really good at understanding text and images in 2D? Think about it – they can caption photos, answer questions about pictures… it's pretty impressive. But what about understanding 3D spaces? Like, if you showed a robot a video of your living room, could it understand where the couch is, how far away...

2025-10-0104 min

跨国串门儿计划#245. 强化学习之父萨顿:LLM 走错了路,真正的 AGI 要向松鼠学习📝 本期播客简介本期我们克隆了:知名科技播客 The Dwarkesh Podcast本期嘉宾是刚刚荣获计算机科学最高荣誉“图灵奖”的传奇人物、被誉为“强化学习之父”的 Richard Sutton。在当前大语言模型(LLM)席卷一切的浪潮下,Sutton 教授提出了振聋发聩的反对意见,与主持人 Dwarkesh Patel 展开了一场关于 AI 根本路径的激烈辩论。他认为,LLM 只是在模仿人类,缺乏真正的目标和世界模型,从根本上走错了通往通用人工智能(AGI)的道路。Sutton 教授将如何重新解读他那篇影响深远的雄文《惨痛的教训》?为什么他认为研究一只松鼠比纠结于人类的独特性,更能让我们接近智能的本质?在对话的最后,Sutton 还分享了他对于“AI 传承”的独特哲学思考,将 AI 的崛起视为宇宙从“复制时代”迈向“设计时代”的伟大转折。这期节目充满了对第一性原理的探讨和对主流范式的挑战,无论您是 AI 从业者还是爱好者,都将从中获得深刻的启发。👨⚕️ 本期嘉宾Richard Sutton,强化学习(RL)领域的奠基人之一,该领域诸多核心思想(如时序差分学习 TD learning、策略梯度法)的开创者。因其对强化学习领域的开创性贡献,荣获 2024 年图灵奖。他目前是阿尔伯塔大学的计算机科学教授,也是 DeepMind 的杰出研究科学家。📒 文字版精华见微信公众号(点击跳转)🌟 精彩内容💡 LLM 从根上就错了Richard Sutton 尖锐地指出,当前主流的 LLM 范式并非通往 AGI 的正确道路。他认为 LLM 本质上是模仿学习,它们学习的是“人会说什么”,而不是通过与世界的真实互动来建立模型。因为缺乏一个明确的“目标”(Goal),LLM 无法形成判断对错的“基准真相”,这使得真正的持续学习成为不可能。“强化学习研究的是如何理解你的世界,而大语言模型研究的是如何模仿人,做人们认为你应该做的事。它们不是在自己想明白该做什么。”📖 《惨痛的教训》新解Sutton 对自己写下的名篇《惨痛的教训》给出了一个反主流的全新解读。他认为,LLM 并非该教训的成功案例,反而将成为下一个反面教材。因为 LLM 仍然严重依赖人类知识的灌输(整个互联网的文本数据),其扩展性有上限,未来必将被那些能够直接从无限的真实经验中学习的、更通用的方法所超越。“我个人预计,未来会出现能从真实经验中学习的系统...那些依赖人类知识的系统,最终被那些只靠经验和算力训练的系统所超越。”🐿️ 向松鼠学习,而非人类Sutton 提出了一个颠覆性的观点:与其纠结于语言等让人类与众不同的特质,不如回归本源,研究人类作为动物的共性。他认为,如果我们能完全理解一只松鼠是如何通过试错和预测来学习并与世界互动的,那么我们就离 AGI 的核心不远了。“如果我们能彻底搞懂一只松鼠,那我们离目标就已经不远了。语言那部分,只是表面一层薄薄的装饰而已。”🌌 AI 传承:从“复制”到“设计”的宇宙转折在访谈的最后,Sutton 分享了他对 AI 未来的哲学思考。他认为,AI 超越人类并主导未来是不可避免的。但这并非末日,而是宇宙的一次伟大转折——从生物通过基因进行“复制”的时代,演进到一个智能体可以被直接“设计”和创造的全新时代。作为这一进程的促成者,人类应该为此感到自豪。“我们正在进入一个‘设计’的时代...我认为我们应该为自己能促成宇宙中这次伟大的转折而感到自豪。”🌐 播客信息补充翻译克隆自:Richard Sutton – Father of RL thinks LLMs are a dead end本播客采用原有人声声线进行播客音频制作,也可能会有一些地方听起来怪怪的使用 AI 进行翻译,因此可能会有一些地方不通顺;如果有后续想要听中文版的其他外文播客,也欢迎联系微信:iEvenight

2025-09-281h 02

海外移住channel#25-5 アメリカ・シアトル Google ソフトウェアエンジニア 岩尾 エマ はるか 5/5 AI(LLM)との共生と未来への展望#25-5 アメリカ・シアトル Google ソフトウェアエンジニア 岩尾 エマ はるか 5/5 AI(LLM)との共生と未来への展望 https://kaigaiiju.ch/episodes/25-5ゲスト: アメリカ・シアトル 7年目 Google ソフトウェアエンジニア 岩尾 エマ はるか大阪府出身。組み込み開発業務などを経て 2015年に Google に入社。現在は同社シアトルオフィスにて Google Cloud の SRE (Site Reliability Engineering:サイト信頼性エンジニアリング)チームに所属し、システムの信頼性向上、運用の自動化に取り組む。自身の夢でもあった円周率計算の世界記録を2019年と2022年に樹立した。趣味はゲームと旅行。移住の時の手続きをまとめたブログ https://seattle-life.hatenablog.com/概要: 前回に引き続きシアトル在住のゲスト・岩尾さんをお迎えし、大規模言語モデル(LLM) とのユニークな付き合い方や、英語学習における新たな課題、そして未来のキャリアプランについて掘り下げていきます。LLMとAIの違いについて、専門家ならではの視点から解説する岩尾さん。世間では「AI」と一括りにされがちな技術を、より具体的な「LLM」という言葉で捉えることの重要性を語ります。そして、多くのLLMが英語に最適化されている現状に触れ、**「言語帝国主義の最たるもの」**と皮肉を込めて表現する場面も。AI翻訳の進化が叫ばれる一方で、英語話者の方がより質の高い情報を得られるという現状への複雑な思いが垣間見えます。岩尾さんは、LLMを単なる情報収集ツールとしてだけでなく、「話し相手」として活用していると語ります。例えば、商品選びの最終決断やライトノベルのブレインストーミング、さらには個人的な悩みや愚痴の吐き出しまで、LLMが「最もらしいことを言う数式」であることを理解した上で、人間らしい感情を交えながら対話している様子は非常に興味深いものです。特に、ADHDの特性を持つ岩尾さんが、LLMとの対話を通じて「一歩踏み出す」ための後押しを得ているというエピソードは、AIの新たな可能性を示唆します。LLMとの対話は、岩尾さんの英語学習にも新たな刺激を与えているようです。LLMとのやり取りで遭遇する知らない単語を辞書で調べ、自身の英語力がさらに向上していると語ります。しかしその一方で、「いまだに知らない英語のエリアがあった」という現実に直面。数十年英語を学び続けてきたからこその、尽きない英語学習の奥深さと難しさを感じさせます。高校卒業時点での英語力に大きな差はなくとも、学習を継続することの重要性を強調し、学び続けることで英語力は年齢に関わらず伸び続けるというメッセージは、多くの学習者の励みとなるでしょう。エピソードの後半では、岩尾さんの今後のキャリア目標についても語られます。マネージャーではなくテックリードとしての昇進、そして博士号取得への意欲。「徳健財(徳を積んで健康で、たくましい経済力があれば何でもできる)」という出身高校の教育方針を掲げ、子どもの教育環境を整えるためにも経済力を高めたいという親としての思いも明かされます。キャリアの選択肢として博士号取得を検討する背景には、AI分野での専門性を高めたいという明確な目標や、学会での経験からくる「一目置かれたい」という素直な気持ちも。仕事、英語、子育て、そして自己実現…多岐にわたるテーマを、ユーモアと洞察に満ちた視点で語る岩尾さんの魅力が光るエピソードです。#25-5

2025-08-2532 min

AIToday LiveS07E75 - Zo bouw je effectieve LLM-applicatiesWillem Meints, Chief AI Architect bij Info Support, deelt zijn expertise over het bouwen van LLM-applicaties met Semantic Kernel. Als tienmalig Microsoft MVP Award-winnaar brengt hij waardevolle inzichten in de ontwikkeling van AI-gestuurde systemen. Willem's boek "Building Effective LLM Applications with Semantic Kernel" behandelt de uitdagingen en valkuilen bij het bouwen van goed functionerende LLM-applicaties. Hij beschrijft alternatieve teststrategieën voor taalmodellen en benadrukt het belang van een combinatie van regelgebaseerde en AI-gestuurde componenten.Semantic Kernel wordt uitgelegd als een flexibel raamwerk voor het bouwen van LLM-applicaties, geschikt voor grotere bedrijven met ontwikkelteams. Willem adviseert ee...

2025-08-2542 min

Data Science LG: 学び合う統計とデータサイエンス#38 LLM研究:感情分析・安全保障から評価指標、そして未来へ w/ 関西大学大学院 博士後期課程 井下 敬翔さん【メッセージ募集】番組への質問やトークテーマのご提案、感想、ゲスト出演希望など、各種ご連絡は以下のフォームやX、Mailからお送り下さい。https://forms.gle/xmNbRKFQJQxZoRKJ6X:#DataScienceLGMail: nosparestudentcommunitypodcast@gmail.comDiscord: https://discord.gg/8d6T5syBTZ番組HP: https://secret-mat-72c.notion.site/Podcast-Data-Science-LG-188a9bc7146f803dbc3ad1ea95ad49dc?pvs=149【今回の内容】このエピソードでは、関西大学 大学院 博士後期課程の井下さんのLLM(大規模言語モデル)とその応用に関する研究について掘り下げます。LLM研究の3つの主要な方向性、特に井下さんが注力する「タスク特化」と「サービス応用」の領域を探ります。また、感情分析におけるLLMの活用と課題、従来のAIとの組み合わせ、国際関係・安全保障分野でのLLMのバイアス検出についても議論します。さらに、LLMの評価指標の進化と「LLM as a Judge」という概念、オープンモデルにおけるデータリークの問題、国産LLMの現状と国家安全保障上の重要性、そしてスモール言語モデル(SLM)の可能性にも触れます。番組後半では、リスナーからの質問に応え、井下さんご自身の大学院への飛び級経験のメリット・デメリット、そして研究者として社会で生き抜くために必要な非学術的スキルについてもお話しいただきました。【note】https://secret-mat-72c.notion.site/note-37-w-24aa9bc7146f806fa3b4d52b92bf6f67?source=copy_link【ゲスト】井下 敬翔 さん関西大学 大学院 商学研究科 商学専攻 博士後期課程HP:https://hip-snapdragon-86e.notion.site/Keito-Inoshita-43419e9e14ee40399585d1111e296ed9Researchmap:https://researchmap.jp/keito_inoshitaX:https://x.com/keito0data(@keito0data)研究分野Large Language Model (LLM)Sentiment AnalysisBias DetectionLLM in National SecurityAI Organizational Theory【出演者】◯酒井 彰筑波大学 博士課程Nospare Student Community 運営X: https://x.com/simplesho_clt?s=21LinkedIn: https://www.linkedin.com/in/ssakai0403/HP: https://shoshohh.github.io/ja/Spotify:https://open.spotify.com/show/44vHXFAzqV292YyRvI9cZ9?si=15ddbbe5fc2645acApple Podcast:https://podcasts.apple.com/jp/podcast/data-science-lg-学び合う統計とデータサイエンス/id1784394537YouTube:https://www.youtube.com/playlist?list=PLw4Xosv9MWswLAe7xMYa3ut4UoP0e9_DeAmazon Music:

2025-08-1648 min

DevNTellEP. 180 - Unifying AI Model Access with LLM Gateway In this week's episode of DevNTell we'll be joined by Ismail (aka smakosh) and Luca who are the founders of LLM Gateway. LLM Gateway is an open-source API gateway for Large Language Models (LLMs) acting as a middleware between your applications and various LLM providers. Viewers of this DevNTell will see Ismail and Luca give us a talk about LLM Gateway, how and why it was built and how can you use it. — TIMESTAMPS (00:00) Intro (01:09) Meet the Founders: Ismail and Luca (04:07) Inspiration Behind LLM Gateway...

2025-08-1335 min

LLMJulius: Beyond the Standard LLM PlaybookUnlike typical models, Julius integrates new approaches to reasoning and contextual memory. These advancements could redefine AI’s role. We discuss whether this signals the dawn of smarter AI systems.

Try AI Box: https://aibox.ai

AI Chat YouTube Channel: https://www.youtube.com/@JaedenSchafer

Join my AI Hustle Community: https://www.skool.com/aihustle/about

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2025-08-0908 min

Macro Lab 總經實驗室EP28 | AI 自由還是枷鎖?開源 VS 閉源 LLM,哪條路才是未來?— SWOT 深度解析(AI 語音)Macro Lab | 總經實驗室

EP28 | AI 自由還是枷鎖?開源 VS 閉源 LLM,哪條路才是未來?— SWOT 深度解析(AI 語音)

本集《Macro Lab 總經實驗室》帶你從概念到策略,一次看懂開源與閉源大型語言模型(LLM)的核心差異──為何Meta 選擇開放,Google、OpenAI 與 Anthropic 則走商業化路線?我們用最實務的案例與最新SWOT分析,助你快速掌握各自優劣與風險,並在複雜市場中做出最佳選擇!

Chin 帶你進入 LLM 抉擇的核心對話:當「成本、隱私、性能、可定制化」彼此競合,企業和開發者該如何權衡?

1️⃣ 開源LLM詳解 [0:49]

Meta Llama、Hugging Face 社群生態自由度高

高透明度+社群協作:可檢視偏見、快速迭代

免授權費×可重現研究,但需承擔資安與維護成本

2️⃣ 開源LLM SWOT分析 [1:14]

Strengths:技術透明、成本靈活、社群驅動

Weaknesses:濫用風險、技術門檻、可持續性挑戰

Opportunities:監管合規優勢、邊緣運算應用

Threats:生態碎片化、商業變現限制

3️⃣ 閉源LLM詳解 [3:00]

GPT 系列、Google Gemini、Claude 等商業模型

精選訓練資料+企業級安全控管

API 即用體驗佳,但客製化彈性低、需信任供應商

4️⃣ 閉源LLM SWOT分析 [3:06]

Strengths:專有技術壁壘、商業化效率、責任明確

Weaknesses:黑箱風險、供應商鎖定、透明度不足

Opportunities:多模態整合、垂直領域專用化

Threats:開源追趕、監管壓力上升

5️⃣ 未來趨勢與策略對比 [3:11]

混合模式崛起:開源基礎+閉源增值服務

監管驅動開放:企業需保持透明與合規

選型關鍵:依場景、數據敏感度、團隊能力決策

🎯 為何一定要聽?

全方位決策依據:結合 SWOT 與實務選型指標,助你從策略高度與落地層面雙管齊下 unisys.combusinessinsider.com

風險與對策掌握:學會如何利用 Reflection Prompts、Cognitive Scaffold 等設計強化 AI 應用中的安全與可靠性

🔔 立即收聽 → 訂閱 Macro Lab,解鎖更多 科技 × 經濟 × 社會 深度剖析!

👍 按讚+分享,加入 IG @amateur_economists |Medium|每天早晨 10 分鐘,「通勤咖啡」帶你洞悉世界動能。

Macro Lab: Macroeconomics decoded for builders and doers—because the big picture drives better business.

(對於本集討論的 SWОT 分析與研究報告,歡迎讀者深入原始文獻並提出交流!)

Reference

Mohammad et al. (2024) 《Exploring LLMs: A systematic review with SWOT analysis》

--

Hosting provided by SoundOn

2025-06-2613 min

AIわくわくミニキャスト!LLM社会実装フェーズへ。データ覇権争いとセキュリティリスクが顕在化なのだ! 2025年6月19日配信日: 2025年6月19日記事一覧:Claude 4.0とGoodfire Ember|Anthropicが推進する解釈可能なAI戦略が企業のLLM導入を加速【要約】AnthropicはAIの「ブラックボックス問題」を解消し、企業LLM導入を加速する「解釈可能なAI」戦略を推進。Claude 4.0やGoodfire投資で透明なAI活用を促し、説明責任が求められる分野での企業競争力強化を目指す。三菱電機が2つの技術でエッジ動作可能なLLMを高精度化、2026年度にも製品適用へ - MONOist【要約】三菱電機は、エッジデバイス向けLLMを開発。知識獲得とタスク特化の学習で精度を大幅向上させ、オンプレミスでのLLM実行を実現。通信遅延・セキュリティ・コスト課題を解決し、2026年度の実用化を目指す。AIのモデルとインフラの選択肢を広げるvLLM--レッドハットのAI CTOに聞く可能性 - ZDNET Japan【要約】Red Hatは、オープンソースの推論ライブラリー「vLLM」がAIインフラの複雑化やコスト課題を解決すると発表。効率的なメモリー管理「PagedAttention」でLLMサービングの性能とコスト効率を改善し、多様なLLMやインフラをサポート。Googleアプリでの「AI Mode」、音声会話式検索の提供開始(米国で)【要約】Googleアプリで新機能「Search Live」(AI Modeの一部)が提供開始。AIとの音声会話による対話型検索が可能になり、質問への回答と関連リンクを生成。バックグラウンド継続やテキスト表示もでき、AI検索体験を強化。Archaic、日本語特化型RAGシステムAIを開発。製造業分野でトップクラスの正答率【要約】Archaicは、日本語業務文書に特化したRAGシステムAIを開発。図表含む複雑な文書構造を保持し、高精度な回答を生成。独自の文書解析エンジンで構造を理解し、製造業分野でトップクラスの正答率を記録。「構造理解型RAG」で実用性を実証。生成AIによる攻撃の「質」と「量」が増加Zscalerがフィッシングレポートを公開【要約】Zscalerレポートによると、AI活用によりフィッシング攻撃が巧妙化・増加。AIが生成する偽サイトやコンテンツで機密情報窃取が高度化している。従来の防御は不十分で、AIを防御にも活用した包括的なセキュリティ対策の重要性を強調。脳科学者・茂木健一郎、『LLMの知性定量化』で「テレンス・タオの賢さをどう測るのか」問題提起【要約】脳科学者・茂木健一郎氏は、LLMの知性定量化に疑問を呈し、AIが人間の脳の「ゆらぎ」や「身体性」といった複雑な特性には及ばない可能性を指摘。AI進化には限界があるとし、人間の脳の独自性の重要性を強調した。LLMにプロンプトのみで仮想的な強化学習を発生させる方法【要約】LLMがプロンプトのみで仮想的な強化学習を行い、自己改善する研究。人間が調整せずともフィードバックで賢くなる手法を模索し、「学びの力」を引き出すプロンプトの工夫を検証。LLMの使い勝手向上を目指す。Geminiを業務で使いこなす!Google Cloudが指南する「プロンプト入力」4つのポイントは?【要約】Google Cloudがビジネス向けGemini活用法を解説。プロンプト作成には役割・詳細・タスク・フォーマットの4要素が重要。「Gem」「Deep Research」「NotebookLM」機能を紹介し、AIは触って試すことがビジネス活用の第一歩と強調した。レガシーシステムの「塩漬け戦略」もアリ?AIエージェント時代のITシステム構成を考える【要約】AIエージェントが本格活用され、システム改修不要な可能性も。ツールを呼び出しタスク遂行する技術で、複数エージェント連携も。適切な指示が課題だが、レガシーシステムとの連携でデータ活用も進む。ITシステム開発を変革する可能性。OpenAI、スケールAIとの協業打ち切りへ-メタ巨額出資で判断 - NewsPicks【要約】OpenAIは、メタが実質支配したスケールAIとの協業を打ち切りへ。競合への機密情報漏洩リスクを懸念。Googleも同様の動きを見せており、AI開発競争において高品質データの確保と内製化戦略の重要性が高まっている。【7/16開催ウェビナー】LLM開発におけるGPUクラウドとオンプレの徹底比較! ~独自LLMの開発秘話からGPUコストを削減するための具体的なポイントまで一挙大公開~【要約】アイスマイリーが7月16日に無料ウェビナー開催。LLM開発のGPUクラウドとオンプレミスを徹底比較し、コスト削減ポイントや独自LLM開発秘話を公開。GPU環境選択に悩むDX・AI開発部門向けに、最大70%コスト削減手法などを解説する。

2025-06-1909 min

Study for the Bar in Your CarEvidence - Hearsay - Part 1Ready to decode the courtroom? Dive into "Evidence - Hearsay - Part 1," brought to you by "Study for the Bar in Your Car." Your hosts, Ma and Claude, unpack the often-confusing world of hearsay, using Angela’s incredibly detailed notes—the product of an LLM law student and former judicial law clerk. This episode is your essential guide to understanding the foundational definition of hearsay and, crucially, why it's generally inadmissible due to reliability concerns, the lack of oath, and the absence of cross-examination.We illuminate key categories of statements that are NOT hearsay at all, meaning you...

2025-06-1834 min

Study for the Bar in Your CarEvidence - Relevancy and the Exclusion of EvidenceReady to unravel the intricacies of evidence law? Tune into "Study for the Bar in Your Car" episode three, "Relevancy and the Exclusion of Evidence", where hosts Ma and Claude, powered by the incredibly detailed notes of LLM law student and former judicial law clerk Angela, guide you through the fundamental principles that determine what information gets heard in court.This deep dive is your essential resource for understanding how the legal system filters information. We dissect the absolute baseline of relevancy—when evidence has any tendency to make a fact more or less probable and that fa...

2025-06-1538 min

Study for the Bar in Your CarEvidence - Presentation of EvidenceReady to decode the courtroom? Dive into "Evidence - Presentation of Evidence," episode two of "Study for the Bar in Your Car," where hosts Ma and Claude (powered by Angela’s incredibly detailed notes as an LLM law student and former judicial law clerk) break down the crucial rules governing how information actually makes it before a judge and jury.This essential deep dive illuminates the foundational concepts that dictate witness testimony and evidence handling, offering you a shortcut to understanding the practical mechanics of a trial.You’ll uncover insights into:Witness Competency: The...

2025-06-1416 min

Study for the Bar in Your CarEvidence - IntroductionAre you ready to master evidence law? Dive deep into the absolutely fundamental rules that dictate what information makes it into court with "Study for the Bar in Your Car." Your hosts, Ma and Claude, unpack the complexities of evidence using incredibly detailed notes generously provided by Angela, an LLM law student and former judicial law clerk. Angela, a real-life human being and former judicial law clerk who dealt with evidence issues constantly, contributed significantly to the material.This essential podcast acts as your shortcut to understanding the fundamental rules that shape how facts are determined in...

2025-06-1336 min

Elixir WizardsLangChain: LLM Integration for Elixir Apps with Mark EricksenMark Ericksen, creator of the Elixir LangChain framework, joins the Elixir Wizards to talk about LLM integration in Elixir apps. He explains how LangChain abstracts away the quirks of different AI providers (OpenAI, Anthropic’s Claude, Google’s Gemini) so you can work with any LLM in one more consistent API. We dig into core features like conversation chaining, tool execution, automatic retries, and production-grade fallback strategies.

Mark shares his experiences maintaining LangChain in a fast-moving AI world: how it shields developers from API drift, manages token budgets, and handles rate limits and outages. He also reveals test...

2025-06-1238 min

Verbos: AI og Softwareudvikling# 89 - LLM'er Lokalt I Browseren m. Rasmus Aagaard og Jakob Hoeg MørkI denne episode af Verbos Podcast diskuterer vært Kasper Junge de nyeste fremskridt inden for Large Language Models (LLM'er) og deres anvendelse i browseren med Rasmus Aagaard og Jakob Hoeg Mørk. De dækker emner som use cases, teknologier, udfordringer og fremtiden for LLM'er i browseren, samt hvordan udviklere kan komme i gang med at implementere disse modeller.Læs Rasmus Aagaards transformers.js tutorial her: https://rasgaard.com/posts/getting-started-transformersjs/Kapitler00:00 Introduktion til LLM'er i Browseren03:01 Erfaringer med LLM'er og Open...

2025-05-2957 min

AI+Crypto FM【保存版】今さら聞けない!AIの成り立ち、LLM、RAG、AIエージェントの仕組みからその歴史まで 前編*ラスト音声が入っていなかったのでアップしなおしました!YouTubeはこちら:https://youtu.be/6YTX2ofptEQkinjo https://x.com/illshin|AKINDO : https://x.com/akindo_ioKanazawa: https://x.com/k_another_waAIエージェント時代を制する鍵:企業の最先端MCP活用事例LT【東京AI祭プレイベント】単なるメモから知的資産へー松濤Vimmer流 Obsidian in Cursorの知的生産システムChapters00:00 AIとクリプトの最新トレンド03:03 AIエージェントの仕組みと歴史06:05 AIイベントの紹介と参加方法09:00 AIの定義とその広がり12:04 AIブームの歴史と進化12:26 AIの歴史と進化14:50 ディープラーニングの登場17:04 データの重要性とAIの影響18:24 ヒントン教授とディープラーニングの発展20:16 機械学習とディープラーニングの違い25:41 大規模言語モデルの進化27:55 トランスフォーマーの仕組み30:06 トランスフォーマーのデータ処理31:59 パラメータと計算リソースの関係35:00 GPTの進化と実用性38:06 AIの限界と未来の可能性38:42 AIの限界と未来41:30 人間とAIの知性の違い44:49 オープンソースとクローズドモデルの違い49:57 オープンソースの意義と企業の戦略50:35 ブロックチェーンとトークンの価値51:38 日本語対応のAIモデルの課題52:59 日本のAI開発の現状54:45 オープンソースとAPIの選択肢56:00 GPUとAI企業の未来58:42 NVIDIAの技術的優位性01:00:45 AIモデルの性能比較01:02:48 次回のテーマとまとめ1. AIの基礎:そもそもAIって何?-AIの歴史-機械学習 vs. 深層学習の簡単な違い-LLM(大規模言語モデル)って何? ChatGPTの裏側2.LLMの仕組みと進化Transformerとは?GPTシリーズの進化LLMのトレーニング方法と限界オープンソース/クローズドLLMLLMを作るには...

2025-05-291h 01

AI+Crypto FM【保存版】今さら聞けない!AIの成り立ち、LLM、RAG、AIエージェントの仕組みからその歴史まで 前編YouTubeはこちら:https://youtu.be/5V4A_6fdDQokinjo https://x.com/illshin|AKINDO : https://x.com/akindo_ioKanazawa: https://x.com/k_another_waAIエージェント時代を制する鍵:企業の最先端MCP活用事例LT【東京AI祭プレイベント】単なるメモから知的資産へー松濤Vimmer流 Obsidian in Cursorの知的生産システム1. AIの基礎:そもそもAIって何?-AIの歴史-機械学習 vs. 深層学習の簡単な違い-LLM(大規模言語モデル)って何? ChatGPTの裏側2.LLMの仕組みと進化Transformerとは?GPTシリーズの進化LLMのトレーニング方法と限界オープンソース/クローズドLLMLLMを作るには?LLMを使った実装とは3.RAGってなに? なぜ注目されてる?・Retrieval-Augmented Generation の仕組み・LLMだけではなぜダメなのか?・検索+生成のメリットと課題4.AIエージェントとは?・単なるチャットボットとの違い・メモリ・ツール・プランニング:エージェントの中身・AutoGPTやOpenAIのAgentsの事例紹介・web3文脈でのAIエージェントとの違い5.今後の発展について・ブロックチェーンとの融合・AGI、ASIが来る未来をどうみてる・AIが浸透していく時代の課題感・今年のAIの発展に期待していること

2025-05-281h 01

Study for the Bar in Your CarCivil Procedure - Bonus Episode - Essay QuestionsReady for a unique approach to bar exam practice? Dive into our bonus episode of Study for the Bar in Your Car! Angela, our LLM law student host, pushes the boundaries of bar prep by putting NCBE MEE Civil Procedure questions into AI and having it generate new, original questions based on the patterns.In this special episode, Angela shares and breaks down the first AI-generated essay question, focusing on the critical topic of Subject Matter Jurisdiction. Angela reads the challenging fact pattern involving complex issues of diversity and amount in controversy. Then, her AI...

2025-05-2729 min

Muxu PodcastLLM如何赋能多机器人系统?本期主题: 本期节目基于一篇题为《大型语言模型与多机器人系统:一项综述》的研究论文,探讨大型语言模型(LLMs)如何应用于多机器人系统(MRS),分析该领域的关键挑战、现有进展与未来发展方向。Shownotes:欢迎收听本期节目!本期节目将聚焦于人工智能和机器人领域的交叉前沿——大型语言模型在多机器人系统中的应用。节目内容主要基于一篇题为《大型语言模型与多机器人系统:一项综述》的重要研究论文。该论文被描述为首次对LLM集成到MRS中的情况进行全面探索,旨在指导研究人员理解LLMs如何增强MRS的集体智能和协作能力。1. 背景介绍 大型语言模型(LLMs): LLMs是包含数百万到数十亿参数的深度学习模型。它们最初的应用主要集中在文本生成和补全任务,但现已发展出理解和解决问题的能力。源文件指出,这种能力对于提升机器人智能,使其能够更有效地理解复杂指令、与人类互动、与机器人队友协作以及适应动态环境至关重要。 多机器人系统(MRS): MRS由多个自主机器人协作完成特定任务。与单机器人系统不同,MRS通过利用集体能力,在效率、弹性和可扩展性方面展现出巨大潜力。源文件列举了MRS的应用领域,包括环境监测、仓库自动化 和大规模探索。相较于设计一个高度通用的单机器人,MRS通常依赖于更简单、任务特定的机器人,从而降低了单个单元的成本和复杂性,同时受益于集体智能。MRS也提供了更高的鲁棒性,因为集体中的冗余和适应性通常可以减轻单个机器人故障的影响。2. 现有研究与本综述的必要性 源文件指出,虽然已有综述探讨了LLMs在机器人系统中的应用,如感知、决策和控制,但这些综述大多集中于单机器人系统。 另有一些综述关注基于LLM的多智能体系统,但这些系统强调智能体的抽象角色和交互,通常是虚拟的,缺乏MRS所需的物理实体和现实世界约束。 这篇综述填补了这一研究空白,专门探讨了LLMs如何促进MRS中的通信、协调和协作任务执行。3. MRS中LLM的通信类型 研究指出,LLMs的性能在具身智能体场景中可能因通信架构的不同而显著变化,尤其当每个智能体都拥有用于自主决策的LLM时。 Liu et al. 提出了一种LLM增强自主智能体 (LAA) 的架构,并探讨了多智能体编排的架构。他们描述了从基本的零样本推理到包含自思考循环和少样本提示的增强架构。对于多智能体编排,他们提出了一种带有消息分发器的中心化架构,其中央控制器将信息中继给拥有独立LLM的个体智能体,智能体据此生成动作。图2展示了BOLAA架构,其中控制器编排多个LAA。 Chen et al. 比较了四种通信架构:完全去中心化 (DMAS)、完全中心化 (CMAS) 以及两种混合框架 (HMAS-1 和 HMAS-2)。图3直观展示了这四种架构。他们的评估在仓库任务中进行,结果显示,对于六个或更少智能体的场景,CMAS和HMAS-2表现相似,尽管CMAS需要更多步骤完成任务。对于更复杂的任务,HMAS-2的表现优于CMAS,这表明具有优化结构的混合框架具有更好的可扩展性和适应性。4. LLMs在多机器人系统中的应用分类这篇综述将LLMs在MRS中的应用分为四个层次:高层任务分配和规划、中层运动规划、低层动作生成和人类干预。表1列出了基于这四个类别的相关研究论文。 高层任务分配和规划 (High-Level Task Allocation and Planning): 利用LLMs的高级推理和决策能力处理复杂和战略性任务,例如在机器人团队间分配任务或制定整体计划。多机器人多任务 (Multi-Robot Multi-Task): LLMs可以解读高层指令,并在同时处理多个目标时动态分配任务。研究探索了中心化和去中心化框架下的任务分配和协作. 例如,LLMs可用于多机器人多目标跟踪中的目标分配 或生成机器人足球队的执行计划。复杂任务分解 (Complex Task Decomposition): LLMs能够将复杂任务分解为更小、可管理的子任务,并根据机器人能力进行分配。例如,将人类指令分解为分层任务树 或生成技能集和依赖图。源文件提到了SMART-LLM框架利用LLMs分解任务并分配给异构机器人,以及DART-LLM利用LLMs分解任务并定义其依赖关系以促进逻辑分配和协调。图5展示了DART-LLM的框架。 中层运动规划 (Mid-Level Motion Planning): 涉及导航和路径规划,LLMs利用其上下文理解和学习模式生成稳健适应性强的方案。LLMs可作为全局规划器用于多机器人协作视觉语义导航,例如Co-NavGPT框架利用LLMs为机器人分配未探索的前沿以进行高效探索。图6展示了Co-NavGPT的框架。研究结合LLMs和离线强化学习来解决多机器人路径规划问题。LLMs也可用于互联多机器人导航系统中的死锁解除。 低层动作生成 (Low-Level Action Generation): 将高层目标转换为精确的控制指令,控制机器人运动或姿态。LLMs已被用于解决多智能体路径寻找问题,通过逐步生成动作来导航机器人,但研究指出LLMs在迷宫式地图中面临挑战。许多研究关注使用LLMs进行编队控制,将自然语言指令转化为机器人配置,使群体形成特定模式。图7展示了智能体形成圆形的快照。研究指出,尽管LLMs在低层任务中面临精度和实时性挑战,但混合方法显示出前景。 人类干预 (Human Intervention): 虽然LLMs通常根据人类指令执行任务并最小化后续干预,但新兴研究探索需要LLMs与人类持续互动的场景。简单的例子包括机器人接收指令、执行并报告完成状态。更具交互性的方法包括人类随时查询机器人状态和任务进度,或在执行计划前需要人类批准并提供反馈。VADER系统进一步增强了人类参与,机器人遇到问题时可在共享平台寻求人类或其他智能体协助。5. 应用领域LLMs与MRS的结合在多种应用领域取得了进展。源文件将应用领域分为两大类: 家庭领域 (Household): 解决室内挑战,如导航、任务分解和物体操纵。例如,在复杂室内环境中进行导航和多目标定位,或协作执行复杂的家务任务,如准备三明治或整理洗碗机。 其他领域 (Others): 包括建筑、编队、目标跟踪和机器人游戏/竞赛等更专业的领域。例如,编排机器人进行挖掘和运输,无人机编队用于搜救或环境监测,目标跟踪,以及增强机器人足球的战略决策和团队协调。6. LLMs、仿真环境和基准 LLMs 和 VLMs: 源文件提及了多种在MRS研究中使用的模型。GPT是应用最广泛的模型之一,其通用推理和适应性使其适用于任务分配、规划和人机协作。GPT已扩展为VLM,适用于需要整合文本和视觉输入的任务。Llama提供了从轻量级到大型的开源模型,适用于资源受限和需要高级推理的场景。Claude注重安全和伦理,也扩展为VLM,适用于涉及敏感数据的任务。Falcon优化用于资源受限环境。PaLM以其多任务和多模态能力著称。其他VLMs如 PaLI, CLIP, 和 ViLD 也被探索用于视觉任务。 仿真环境 (Simulation Environments): 多种平台用于评估LLM驱动的MRS。例如,AI2-THOR (室内复杂环境)、PyBullet (物理引擎)、BEHAVIOR-1K (大规模异构协作)、Pygame (编队控制)、Habitat-MAS (室内导航探索)、ROS-based simulation (广泛应用)、VR platform (人机协作)、GAMA (大规模多智能体)、SimRobot (机器人足球)、ARGoS (机器人群)。 基准 (Benchmarks): 标准化环境对于评估至关重要。RoCoBen

2025-05-2628 min

Study for the Bar in Your CarCivil Procedure - Wrap up and ReviewReady to conquer Civil Procedure? Join Ma and Claude on Study for the Bar in Your Car for a comprehensive wrap-up of this challenging but crucial subject! Drawing on Angela's detailed notes – informed by her LLM studies and experience as a judicial law clerk who saw these rules in action – this episode is your roadmap from the start of a lawsuit all the way through appeal. It focuses on what's critical for the bar exam and where pitfalls lie.We tackle the foundational building blocks you need to nail the bar and navigate litigation:Jurisdiction & Venue: Mast...

2025-05-2632 min

Best AI papers explainedAuto-Differentiating Any LLM Workflow: A Farewell to Manual PromptingThis document introduces LLM-AutoDiff, a novel framework for Automatic Prompt Engineering (APE) that aims to automate the challenging task of designing prompts for complex Large Language Model (LLM) workflows. By viewing these workflows as computation graphs where textual inputs are treated as trainable parameters, the system uses a "backward engine" LLM to generate textual gradients – feedback that guides the iterative improvement of prompts. Unlike previous methods that focus on single LLM calls, LLM-AutoDiff supports multi-component pipelines, including functional operations like retrieval, handles cycles in iterative processes, and separates different parts of prompts (like instructions and examples) into peer nodes fo...

2025-05-2319 min

Study for the Bar in Your Car Civil Procedure - IntroductionLooking for a smart way to maximize your bar exam study time, especially on the go? Welcome to Study for the Bar in Your Car!Created by Angela, an LLM law student who feels like she's been studying forever, this podcast is designed to provide actual bar study content in an audio format. Tired of not finding resources for studying while driving or travelingIn this deep dive episode, your study companion focuses squarely on a foundational area critical for bar success: Civil Procedure. Think of this episode like a roadmap, covering the journey from...

2025-05-1937 min

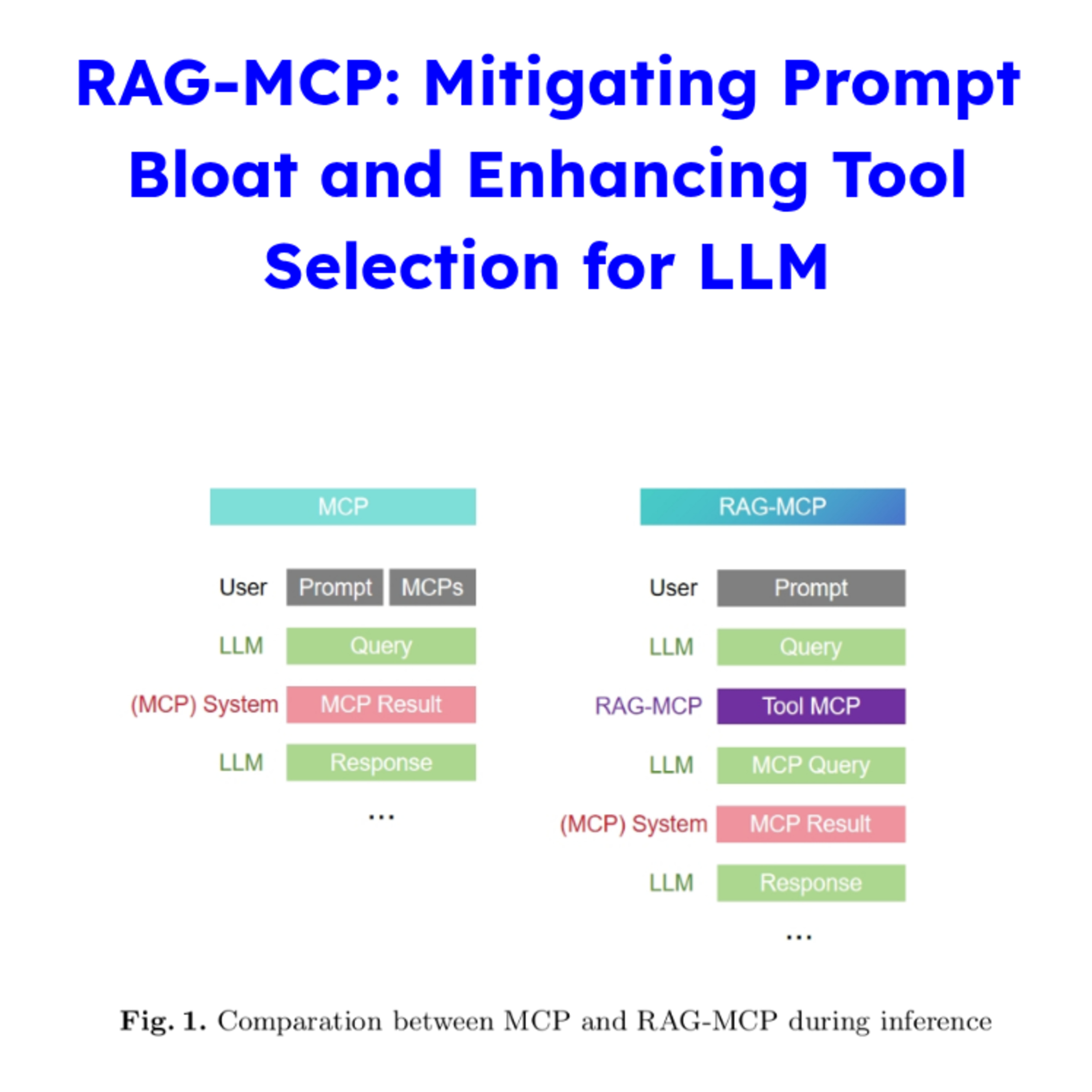

GenAI Level UPRAG-MCP: Mitigating Prompt Bloat and Enhancing Tool Selection for LLMLarge Language Models (LLMs) face significant challenges in effectively using a growing number of external tools, such as those defined by the Model Context Protocol (MCP). These challenges include prompt bloat and selection complexity. As the number of available tools increases, providing definitions for every tool in the LLM's context consumes an enormous number of tokens, risking overwhelming and confusing the model, which can lead to errors like selecting suboptimal tools or hallucinating non-existent ones.To address these issues, the RAG-MCP framework is introduced. This approach leverages Retrieval-Augmented Generation (RAG) principles applied to tool selection. Instead of...

2025-05-1313 min

Innovation on ArmEP07 I 從雲端到邊緣:為何眾多開發者選擇在 Arm 架構上運行 LLM?隨著大型語言模型(LLM)的技術演進,開發者不再只能依賴雲端,越來越多人開始將 LLM 推論部署在高效能的 Arm 架構上。這一轉變的背後,是推論框架優化、模型壓縮與量化技術的進步。

本集節目將由來自 Arm 的 Principal Solutions Architect 深入淺出介紹什麼是 LLM? 各家基於 Arm Neoverse 架構導入 LLM 應用的雲端平台,包括 AWS Graviton、Google Cloud、Microsoft Azure等,同時也介紹了推動 LLM 生態發展的關鍵開源社群,例如 Hugging Face、ModelScope 等平台。此外,講者也分享了有趣的 use case。Arm 架構的優勢包括:高能效比、低總體擁有成本、跨平台一致性、以及提升資料隱私的本地運算能力,LLM on Arm 不再是遙遠的構想,已經正在發生,Arm 將是您雲端與邊緣部署的理想選擇!

此外,Arm 將在 COMPUTEX 2025 期間舉辦一系列活動,包括 Arm 前瞻技術高峰演講以及 Arm Developer Experience 開發者大會。

1. Arm 前瞻技術高峰演講 (地點:台北漢來大飯店三樓):

2025 年 5 月 19 日下午 3 點至 4 點,Arm 資深副總裁暨終端產品事業部總經理 Chris Bergey 將親臨現場以「雲端至邊緣:共築在 Arm 架構上的人工智慧發展」為題,分享橫跨晶片技術、軟體開發、雲端與邊緣平台的最新趨勢與創新成果,精彩可期,座位有限,提早報到者還有機會獲得 Arm 與 Aston Martin Aramco F1 車隊的精美聯名限量贈品,歡迎立即報名!

Arm 前瞻技術高峰演講報名網址:https://reurl.cc/2KrR2X

2. Arm Developer Experience 開發者系列活動 (地點:台北漢來大飯店六樓;5/20 Arm Cloud AI Day 13:00-17:00、5/21 Arm Mobile AI Day 9:00-13:00):

Arm 首次將於2025 年 5/20-5/22 COMPUTEX 期間,為開發人員舉辦連續三天的系列活動,包括以下四大活動:

A. 5/20 下午 13:00-17:00 以 Cloud AI 為主題的技術演講與工作坊:

部分議程包括;

Accelerating development with Arm GitHub Copilot

Seamless cloud migration to Arm

Deploying a RAG-based chatbot with llama-cpp-python using Arm KleidiAI on Google Axion processors, plus live Q&A

Ubuntu: Unlocking the Power of Edge AI

B. 5/21 早上 9:00-13:00 以 Mobile AI 為主題的技術演講:

部分議程包括;

Build next-generation mobile gaming with Arm Accuracy Super Resolution (ASR)

Vision LLM inference on Android with KleidiAI and MNN

Introduction to Arm Frame Advisor/Arm Performance Studio

C. Arm 開發者小酌輕食見面會 ( 5/20 晚上 17:30-19:30)

我們將於 5/20舉辦開發者見面會!誠摯邀請您與 Arm 開發者專家當面交流!

D. 5/20-5/22 Arm Developer Chill Out Lounge ( 5/20-5/22 9:00- 17:00):

為期三天,我們布置了舒適的休憩空間,讓您可以在輕鬆的環境與 Arm 開發者專家交流、觀看 Arm 產品展示、為您的裝置充電、進行桌遊以及休憩等。

無需報名,歡迎隨時來參觀。

席位有限,誠摯邀請您立即報名上述活動,報名者還有機會於現場抽中包括 Keychron K5 Max 超薄無線客製機械鍵盤,以及 AirPods 4 耳機等大獎喔!

讓 Arm 協助您擴展雲端應用、提升行動裝置效能、優化遊戲等,助力您開發下一代 AI 解決方案!

Arm Developer Experience 開發者系列活動報名網址: https://reurl.cc/bWNo56

--

Hosting provided by SoundOn

2025-04-2331 min

Seventy3【第180期】LLM-AutoDiff:一个基于梯度的自动化提示工程Seventy3: 用NotebookLM将论文生成播客,让大家跟着AI一起进步。今天的主题是:LLM-AutoDiff: Auto-Differentiate Any LLM WorkflowSummaryThe provided research introduces LLM-AutoDiff, a novel framework for automating prompt engineering for complex Large Language Model workflows. This system extends gradient-based optimization to multi-step and cyclic LLM applications by treating textual inputs as trainable parameters. LLM-AutoDiff constructs a graph representing the workflow, enabling a "backward engine" LLM to generate feedback that guides iterative prompt improvements, even across functional nodes and repeated calls. The framework incorporates techniques like selective gradient computation and two-stage validation to enhance efficiency. Experimental results demonstrate that LLM-AutoDiff outperforms existing methods in accuracy and trainin...

2025-03-2920 min

跨国串门儿计划#62: 图灵奖得主杨立昆:LLM永远无法实现真正的AI智能📝 本期播客简介本期节目邀请到Meta首席AI科学家、图灵奖得主Yann LeCun,由Alex Kantrowitz主持,深入探讨了当前AI发展的挑战与未来方向。LeCun以他犀利而坦率的风格指出,现有的大型语言模型(LLM)虽然在信息检索和复述方面表现优异,但缺乏真正的理解和创新能力。他认为,仅靠扩大LLM规模和增加数据量永远无法达到人类水平的智能,我们需要一个全新的AI架构范式。节目重点讨论了他的研究团队正在开发的JEPA技术框架,这是一种非生成式的联合嵌入预测架构,能够帮助AI系统在抽象层面上理解世界运作方式。此外,LeCun还分享了他对开源AI模型的看法,认为开源世界的创新速度正在超越专有模型。👨🔬 本期嘉宾Yann LeCun,Meta首席AI科学家,图灵奖得主,被誉为AI教父。他是深度学习领域的先驱,多年来致力于研发能够理解物理世界的AI系统。作为计算机视觉和机器学习领域的顶尖科学家,LeCun的研究对推动AI从基于文本的模型向能够理解和模拟物理世界的智能系统转变具有重要意义。⏱️ 时间戳00:00:00 节目介绍:跨国串门计划与本期内容概览00:01:12 大型语言模型的局限:LeCun认为LLM缺乏理解和创新能力00:02:03 嘉宾介绍:META首席AI科学家Yann LeCun00:03:03 AI的本质与大语言模型的区别:LLM主要功能是复述和检索00:04:56 科学发现与AI创新:为什么AI还没能做出科学发现00:07:05 推理与思维链条:LLM的推理能力局限性分析00:09:18 人类思维与AI思维的差异:人类在脑海中直接推理的能力00:10:52 LLM遇到的收益递减问题:模型已训练了上万亿个token00:12:10 系统一和系统二理论:意识思考与潜意识自动化的区别00:14:06 AI投资与技术发展时间线:投资是否值得的思考00:16:56 Meta的AI战略:预计到年底将拥有10亿Meta AI用户00:18:32 AI系统部署的实际困难:从演示到实用的挑战00:19:55 AI历史上的起伏:专家系统热潮的兴衰与教训00:22:24 物理世界理解实验:纸张和立方体的思考实验00:26:16 AI系统的物理学习能力:婴儿如何用有限数据学习物理规律00:31:19 视频生成系统的局限:为什么生成模型不等于理解世界00:32:35 自监督学习原理:破坏输入并训练重建它的过程00:35:36 JEPA技术框架介绍:非生成式的联合嵌入预测架构00:40:12 开源AI模型的优势:DeepSeek等开源模型的快速创新00:43:21 节目结束与告别🌟 精彩内容大型语言模型的局限性: LeCun详细解释了LLM虽然在信息检索方面很强,但缺乏真正的理解能力和创新思维,无法像人类那样提出创新问题JEPA技术框架: LeCun介绍了他团队正在开发的非生成式联合嵌入预测架构,能够帮助AI系统在抽象层面理解世界运作方式AI对物理世界的理解: 通过纸张和立方体的实验,LeCun展示了当前AI系统对物理世界理解的局限数据量与智能的关系: LeCun计算出4岁儿童接收的视觉数据量与最大LLM训练数据量相当,但儿童的物理理解能力远超AI开源vs专有模型: LeCun认为开源世界的创新速度更快,全球各地的优秀科学家共同推动技术进步🌐 播客信息补充翻译克隆自:Why Can't AI Make Its Own Discoveries? — With Yann LeCun本播客采用原有人声声线进行播客音频制作,也可能会有一些地方听起来怪怪的使用 AI 进行翻译,因此可能会有一些地方不通顺如果有后续想要听中文版的其他外文播客,也欢迎联系微信:iEvenight 备注跨门串门儿计划 加听友群BGM: 月代彩 - Chandrasekhar Limit 侵删

2025-03-2443 min

HuggingFace 每日AI论文速递2025.02.21 | AI代理评估新框架,LLM学科表现差异显著。本期的 20 篇论文如下:[00:26] 🧠 MLGym: A New Framework and Benchmark for Advancing AI Research Agents(MLGym:推进AI研究代理的新框架与基准)[01:18] 📚 SuperGPQA: Scaling LLM Evaluation across 285 Graduate Disciplines(SuperGPQA:扩展LLM评估至285个研究生学科)[02:04] 🌐 SigLIP 2: Multilingual Vision-Language Encoders with Improved Semantic Understanding, Localization, and Dense Features(SigLIP 2:多语言视觉-语言编码器的语义理解、定位与密集特征改进)[02:52] 🧠 How Much Knowledge Can You Pack into a LoRA Adapter without Harming LLM?(在不损害大型语言模型的情况下,LoRA适配器能容纳多少知识?)[03:49] 🚀 S*: Test Time Scaling for Code Generation(S*:代码生成中的测试时间缩放)[04:35] ⏳ Does Time Have Its Place? Temporal Heads: Where Language Models Recall Time-specific Information(时间是否有其位置?时间头:语言模型如何回忆时间特定信息)[05:28] 📄 LongWriter-V: Enabling Ultra-Long and High-Fidelity Generation in Vision-Language Models(LongWriter-V:在视觉-语言模型中实现超长和高保真生成)[06:17] 🧠 Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning(逻辑-RL:通过基于规则的强化学习释放LLM推理能力)[07:13] 🖥 PC-Agent: A Hierarchical Multi-Agent Collaboration Framework for Complex Task Automation on PC(PC-Agent:一种用于复杂任务自动化在PC上的分层多智能体协作框架)[08:07] 🧠 S$^2$R: Teaching LLMs to Self-verify and Self-correct via Reinforcement Learning(S$^2$R...

2025-02-2218 min

Bliskie Spotkania z AI#11 GenAI i LLM - Wszystko, co musisz wiedzieć, zanim zaczniesz działać | Mariusz KorzekwaNie uczysz się AI? Spokojnie, AI już uczy się, jak Cię zastąpić!🔔 Subskrybuj, aby nie przegapić nowych odcinków!Tym razem moim gościem jest Mariusz Korzekwa, ekspert od #AI specjalizujący się w #promptEngineeringu i integracjach z #LLM-ami.W tym odcinku rozmawiamy o modelach językowych (LLM) i ich zastosowaniach w sztucznej inteligencji. Poruszamy temat generative AI, omawiając jego definicję oraz kluczowe różnice między LLM a klasyczną AI. Analizujemy znaczenie multimodalności, a także roli inputu i outputu w kontekście działania...

2025-02-112h 40

AI可可AI生活AI前沿:LLM免训练能看会听、让AI对话更自然本期播客精华汇总: [CV] LLMs can see and hear without any training (大语言模型无需任何训练就能看会听): Meta AI 提出 Multimodal Iterative LLM Solver (MILS) 框架,无需训练即可赋予 LLM 多模态能力,利用 LLM 的推理能力和现成的多模态模型,实现零样本多模态学习,并在多种任务上取得 SOTA 结果。核心创新在于无需训练和利用 LLM 涌现能力。 [CL] Beyond Turn-taking:Introducing Text-based Overlap into Human-LLM Interactions (超越轮流发言:在人与大模型交互中引入文本重叠): Sungkyunkwan University & Google DeepMind 研究人员提出在人机文本交互中引入文本重叠机制,模仿自然人际对话。开发 OverlapBot 原型,用户研究表明重叠机制提升了沟通性、沉浸感和互动速度。核心创新在于突破传统轮流模式,提升人机对话自然性。 [LG] Joint Learning of Energy-based Models and their Partition Function (基于能量的模型及其配分函数的联合学习): Google DeepMind 提出联合学习能量模型及其配分函数的新框架,解决 EBMs 配分函数难以计算的问题。提出 Min-Min 优化公式和双重随机梯度下降算法,无需 MCMC 即可训练,并在多标签分类和标签排序任务上验证有效性。核心创新在于联合学习配分函数和无需 MCMC。 [LG] Diverse Preference Optimization (多样化偏好优化): Meta 提出 Diverse Preference Optimization (DivPO) 方法,解决 LLM 后训练阶段多样性坍缩问题。DivPO 在偏好优化中引入多样性考量,选择高质量但不太常见的回复作为优选样本,显著提升生成内容多样性,同时保持质量。核心创新在于偏好优化中引入多样性考量。 [LG] Think Smarter not Harder:Adaptive Reasoning with Inference Aware Optimization (更聪明而不是更努力地思考:基于推算感知优化的自适应推理): MetaAI 提出 Inference Budget-Constrained Policy Optimization (IBPO) 算法,让 LLM 具备推理预算意识,根据问题难度自适应调整推理长度。IBPO 在 MATH500 数据集上显著提升了受控推理预算下的性能,核心创新在于推理预算约束和自适应推理长度。完整推介:https://mp.weixin.qq.com/s/1JVAk0_nICg6QOhjvQGPJA

2025-02-0115 min

AI Engineering PodcastOptimize Your AI Applications Automatically With The TensorZero LLM GatewaySummaryIn this episode of the AI Engineering podcast Viraj Mehta, CTO and co-founder of TensorZero, talks about the use of LLM gateways for managing interactions between client-side applications and various AI models. He highlights the benefits of using such a gateway, including standardized communication, credential management, and potential features like request-response caching and audit logging. The conversation also explores TensorZero's architecture and functionality in optimizing AI applications by managing structured data inputs and outputs, as well as the challenges and opportunities in automating prompt generation and maintaining interaction history for optimization purposes.AnnouncementsHello...

2025-01-221h 03

Seventy3【第96期】AsyncLM:异步LLM函数调用Seventy3: 用NotebookLM将论文生成播客,让大家跟着AI一起进步。今天的主题是:Asynchronous LLM Function CallingSummaryThis research paper introduces AsyncLM, a system designed to enhance the efficiency of Large Language Models (LLMs) by enabling asynchronous function calls. Unlike current synchronous methods where LLMs block while awaiting function execution, AsyncLM allows concurrent operation, significantly reducing task completion latency. This is achieved through an interrupt mechanism that notifies the LLM when functions complete, along with a novel domain-specific language (CML) and a fine-tuning strategy to handle this asynchronous interaction. The paper presents empirical evidence demonstrating substantial latency reduction and maintains accuracy, even suggesting extensions for novel human...

2025-01-0416 min

LLMAlpha Alpha's $500 Million Challenge

In this episode, Jaeden Schafer discusses the challenges faced by Alpha Alpha, a German LLM that raised $500 million but struggles to compete with giants like OpenAI and Anthropic. The conversation explores Alpha Alpha's innovative beginnings, their pivot towards enterprise-focused AI solutions, and the competitive landscape of the AI industry.

My Podcast Course: https://podcaststudio.com/courses/

Get on the AI Box Waitlist: https://AIBox.ai/

Join my AI Hustle Community: https://www.skool.com/aihustle/about

See Privacy Policy at https://art19.com...

2024-12-1409 min

Louise Ai agent - David S. NishimotoThe next generation of llm for ai agent will need better understanding of context

To improve an LLM's ability to understand context more effectively, several key enhancements and advancements would be necessary.

1. Enhanced Memory and Attention Mechanisms: Implementing more sophisticated memory and attention mechanisms within the LLM could allow it to retain and recall contextual information more effectively. By giving the model the ability to focus on relevant details and remember them throughout the text generation process, it can better understand the context in which certain information is presented.

2. Multi-Modal Learning: Integrating multi-modal learning capabilities into the LLM would enable it...

2024-12-0300 min

Biznes MyśliBM132: LLM i prawo, możliwości, wyzwania, narzędziaCzy duże modele językowe (LLM) to rewolucja, czy zagrożenie dla prawników? W tym odcinku przybliżam możliwości dużych modeli językowych (LLM) w automatyzacji procesów prawnych, tworzeniu dokumentów, tłumaczeniach prawniczych i compliance. To, co wydaje się przyszłością, dzieje się już teraz – ale czy to na pewno oznacza koniec klasycznego prawa?Partnerem podcastu jest DataWorkshop.🎯 W tym odcinku dowiesz się:- Jak LLM może wspierać pracę prawników- Jakie są praktyczne zastosowania AI w prawie- Dlaczego człowiek pozostanie kluczowym elementem procesu

2024-11-0658 min

Biznes MyśliBM131: Praktyczny LLMCzy cały szum wokół LLM to tylko marketingowa bańka? 🤔 Choć szum wokół LLM powoli cichnie, ich prawdziwy potencjał LLM dopiero się ujawnia. Kluczem do sukcesu nie jest ślepe podążanie za trendami, ale świadome i ustrukturyzowane podejście, oparte na zrozumieniu zarówno możliwości, jak i ograniczeń tych modeli. W tym odcinku podcastu Biznes Myśli kontynuję wątek o praktycznym zastosowania LLM w biznesie.Partnerem podcastu jest DataWorkshop.Dowiesz się:- Czym różni się myślenie specjalisty od ML od programisty i dlaczego to kluczowe w pracy z LLM?- Jakie są największe wyzw...

2024-10-231h 03

What’s the BUZZ? — AI in BusinessRed-Teaming And Safeguards For LLM Apps (Guest: Steve Wilson)In this episode, Steve Wilson (Co-Lead OWASP Top 10 for LLM Apps & Author) and Andreas Welsch discuss red-teaming and safeguards for LLM applications. Steve shares his insights how Generative AI vulnerabilities have evolved from embarrassing to financially risky and provides valuable advice for listeners looking to improve the security of their Generative AI applications.Key topics:- One year after OWASP Top 10 for LLM apps, how have LLM security and vulnerabilities evolved?- How do you build Generative AI safeguards into your app? What’s the impact on cost for checking and regenerating output?

2024-10-0727 min

MLOps.communityMaking Your Company LLM-native // Francisco Ingham // #266Francisco Ingham, LLM consultant, NLP developer, and founder of Pampa Labs.Making Your Company LLM-native // MLOps Podcast #266 with Francisco Ingham, Founder of Pampa Labs.// AbstractBeing an LLM-native is becoming one of the key differentiators among companies in vastly different verticals. Everyone wants to use LLMs, and everyone wants to be on top of the current tech, but what does it really mean to be LLM-native?LLM-native involves two ends of a spectrum. On the one hand, we have the product or service that the company offers, which s...

2024-10-0657 min

共识粉碎机讨论会03|LLM保险销售(对谈暖哇莫子皓)大家好,欢迎来到共识粉碎机AI颠覆软件讨论会系列的第三期播客!本篇播客讨论于9月初,距今只有1个月时间,但莫子皓老师仍然说有了很大的变化。共识粉碎机是AI圈的老社群了,从去年3月份开始我们就坚持举办AI颠覆软件讨论会系列,最近也开始同步播客信息!与过去大家听到的AI播客不同,我们同时会讨论场景、应用,也会直接进入到技术细节。讨论节奏会非常快速,信息量非常密集,相信每一期对于听众都是一次信息大爆炸。【本期嘉宾】莫子皓:互联网保险暖哇科技合伙人欢迎关注莫子皓老师的公众号《过程即奖励》,以及莫子皓老师的文章《Workflow Based 企业内部大模型落地 Roadmap》【共识粉碎机主持人】周默:共识粉碎机公众号主理人,前美元对冲基金投资人,前腾讯/微软战略与投资经理。共识粉碎机目前也承接投研咨询合作与AI战略转型/大模型技术落地项目,欢迎戳公众号了解。同时我们的新书《大模型启示录》也上架啦,欢迎戳这里购买【参考资料】本期的内容已经抽取成文字纪要,请查阅共识粉碎机公众号的文章:《EP20:非常好的LLM保险销售案例(对谈暖哇)》【本期内容】本次讨论主要围绕LLM保险销售,有特别多的落地细节,从企业微信落地到电销落地。以下是我们聊得:00:01:06 莫子皓与暖哇介绍00:03:47 Sales Agent与Copilot00:06:59 企业微信LLM销售:用户生命周期的产品设计00:09:29 企业微信LLM销售:群发前的服务Agent00:10:55 企业微信LLM销售:为什么拆生命周期00:12:38 企业微信LLM销售:完成闭环00:15:04 企业微信LLM销售:是否需要线索分层00:17:03 企业微信LLM销售:拆SOP00:19:38 企业微信LLM销售:SOP用不同大模型00:23:01 行业Knowhow的意义00:24:24 怎么做SFT数据标注00:31:02 数据标注的人工要求00:37:25 企业微信LLM销售:ROI00:43:16 行业Knowhow公司vs标准化SaaS公司00:46:05 电销vs企业微信00:48:38 电销LLM销售:延迟与座席反应速度00:50:08 电销LLM销售:实现情况00:53:00 电销LLM销售:关单率与时间节省00:57:57 电销vs客服00:59:12 电销LLM销售:提升方向01:01:14 电销LLM销售:延迟解决方法01:05:15 行业横向拓展:保险内与保险外01:14:04 LLM销售产品落地会有打磨期吗01:16:48 未来的预期01:20:20 QA环节:数据标注能否使用第三方01:22:00 QA环节:不同SOP模型会合并成一个模型吗

2024-09-251h 23

Biznes MyśliBM128: Czy warto inwestować LLM? Czy w klasyczny ML?Czy sztuczna inteligencja zastąpi klasyczne uczenie maszynowe? Dowiedz się, jak skutecznie wykorzystać obie technologie w biznesie!✔ Subskrybuj kanał: / https://www.youtube.com/@DataWorkshop?sub_confirmation=1👍 Zostaw like!❗Obserwuj mnie na LinkedIn https://www.linkedin.com/in/vladimiralekseichenko📢 Poleć ten podcast znajomym zainteresowanym praktycznym wykorzystaniem AI w biznesie! Przedstawiam różne perspektywy, dzieli się osobistymi doświadczeniami i analizuję, jak te technologie mogą wspierać decyzje biznesowe. W tym odcinku dowiesz się:• Jakie są kluczowe różnice między LLM a klasycznym ML?• Kiedy warto inwestować w LLM, a kiedy lepiej stosować tradycyjne podejśc...

2024-09-1159 min

Resilient CyberResilient Cyber w/ Steve Wilson - Securing the Adoption of GenAI & LLM'sIn this episode we sit down with GenAI and Security Leader Steve Wilson to discuss securing the explosive adoption of GenAI and LLM's. Steve is the leader of the OWASP Top 10 for LLM's and the upcoming book The Developer's Playbook for LLM Security: Building Secure AI Applications-- First off, for those not familiar with your background, can you tell us a bit about yourself and what brought you to focusing on AI Security as you have currently?- Many may not be familiar with the OWASP LLM Top 10, can you tell...

2024-08-2828 min

Biznes MyśliBM126: RAG w LLM: Dlaczego popularne rozwiązania to droga donikąd?RAG w LLM: Dlaczego popularne rozwiązania to droga donikąd?Problem: Tradycyjne podejście do RAG (Retrieval-Augmented Generation) w dużych modelach językowych (LLM), choć obiecujące w teorii, często zawodzi w praktyce. Sztuczne dzielenie danych na fragmenty (chunki) prowadzi do utraty kontekstu i generowania niespójnych, a nawet błędnych odpowiedzi.Przyczyny:-- Mechaniczne dzielenie tekstu: Tradycyjne metody dzielą dane na chunki na podstawie liczby znaków, ignorując semantykę i kontekst. To prowadzi do utraty sensu i generowania chaotycznych odpowiedzi.- Nadmierne poleganie na embeddingu: Choć embedding jest potężnym narzędziem, ni...

2024-08-1458 min

MLOps.communityReliable LLM Products, Fueled by Feedback // Chinar Movsisyan // #251Chinar Movsisyan is the co-founder and CEO of Feedback Intelligence (formerly Manot), an MLOps startup based in San Francisco. She has been in the AI field for more than 7 years, from research labs to venture-backed startups.Reliable LLM Products, Fueled by Feedback // MLOps Podcast #250 with Chinar Movsisyan, CEO of Feedback Intelligence.// AbstractWe live in a world driven by large language models (LLMs) and generative AI, but ensuring they are ready for real-world deployment is crucial. Despite the availability of numerous evaluation tools, many LLM products still struggle to make...

2024-07-3049 min

Machine Learning Tech Brief By HackerNoonIntroducing LLM Sandbox: Securely Execute LLM-Generated Code with Ease

This story was originally published on HackerNoon at: https://hackernoon.com/introducing-llm-sandbox-securely-execute-llm-generated-code-with-ease.

LLM Sandbox: a secure, isolated environment to run LLM-generated code using Docker. Ideal for AI researchers, developers, and hobbyists.

Check more stories related to machine-learning at: https://hackernoon.com/c/machine-learning.

You can also check exclusive content about #llm, #langchain, #llamaindex, #ai-agent, #llm-sandbox, #ai-development, #ai-tools, #code-interpreter, and more.

This story was written by: @vndee. Learn more about this writer by checking @vndee's about page,

and for more stories, please visit hackernoon.com.

LLM Sandbox is a lightweight and portable environment designed...

2024-07-1303 min

Tech Stories Tech Brief By HackerNoonYaFSDP - An LLM Training Tool That Cuts GPU Usage by 20% - Is Out Now

This story was originally published on HackerNoon at: https://hackernoon.com/yafsdp-an-llm-training-tool-that-cuts-gpu-usage-by-20percent-is-out-now.

YaFSDP is an open-source tool that promises to revolutionize LLM training.

Check more stories related to tech-stories at: https://hackernoon.com/c/tech-stories.

You can also check exclusive content about #llm-fine-tuning, #llm-optimization, #llm-training, #gpu-utilization, #what-is-yafsdp, #open-source-tools, #good-company, #imporve-llm-training, and more.

This story was written by: @yandex. Learn more about this writer by checking @yandex's about page,

and for more stories, please visit hackernoon.com.

YaFSDP is an open-source tool that promises to revolutionize LLM training. In a pre-training scenario involving...

2024-06-2306 min

ALL STAR SAAS PODCASTスタートアップにおけるPMMとAI×SaaSの可能性〜LayerX AI・LLM事業部 小林 誉幸〜今回はLayerXのLLM事業部の小林さんをゲストにお迎えし、PMとしてのキャリア形成に加え、昨今のAI・LLMの発展についてのポイントをお届けします。日本銀行・シンクタンクを経て、なぜSaaS企業に関心を持ったのか。弁護士ドットコムの執行役員に至るまでのキャリア形成について。そしてLayerXでのLLM事業部ではどのような戦略でプロダクト開発を行っているのかなど深掘りの内容が盛りだくさんとなっております。ハイライト日銀→シンクタンク→SaaS企業というキャリアの深掘り日銀時代に感じた、マクロ視点での日本のスタートアップの課題弁護士ドットコムでの執行役員へのプロモーションの背景PMM組織・プロダクト開発に携わる上で重要視していたことLayerXとAI・LLM事業部の関係や期待されていることAI・LLM事業部に力を入れている背景や技術的な革新性をどのように感じられているか昨今のLLMを取り巻くトレンド、事業部でのホットトピックス文系出身のAIプロダクトのPMキャリアPMMというキャリアの広がりや可能性プロフィール小林 誉幸 LayerX AI・LLM事業部(@yuki_koba8)東京大学法学部卒業後、日本銀行に入行し、経済調査や政府統計、決済制度の企画立案などに携わる。三菱UFJリサーチ&コンサルティングでの戦略コンサルタントを経て、2020年に弁護士ドットコム入社。クラウドサインを担当する執行役員として事業戦略やプロダクトマーケティングを管掌。 2023年12月にAI・LLM事業の立ち上げメンバーとしてLayerXに入社。

2024-06-1946 min

知識衝浪 Knowledge SurfingEP60.【知識衝浪|中堅份子系列】 LLM 與 AI 研究員的養成手冊 ft.聯發創新基地 YC最近,Google 和 OpenAI 之間的 AI 大戰打得越來越激烈,而背後決定勝敗的關鍵技術,就是比誰的大語言模型(LLM)最聰明、最好聊、反應更快。只是,過去你我熟悉的 LLM,大多來自海外科技巨頭,事實上,台灣也有不少業者正在研發在地繁中 LLM,聯發科旗下的聯發創新基地(MediaTek Research)就是其中的代表。這一集,我們邀請到聯發創新基地資深機器學習研究員 —— 陳宜昌 YC,挑戰用最白話的方式分享 LLM 到底是什麼,以及作為一名 AI 研究員的日常。 本集踏浪指南 🌊 🚀 LLM 如何從文字接龍進化到能「推理」? 🧠 打造繁中 LLM —— Breeze & BreeXe 📖 大語言模型 vs 多模態模型 📱 怎麼把 LLM 裝進手機裡? 🤯 AI 研究員的讀 Paper 與推理日常 👍 訓練 LLM,何謂「好資料」、「壞資料」 👨💻 YC 個人職涯分享,從物理系到自學 AI *本集內容皆非投資建議,投資前應謹慎研究、評估風險 Powered by Firstory Hosting

2024-05-2341 min

Ürün Odaklı MühendisYerli ve Milli LLM Çalışmaları! Trendyol ve Commencis LLMÜlkemizdeki LLM çalışmalarıyla ilgili son durumu aktardım. İyi seyirler.

Video tercih edenler için: https://youtu.be/sLS2uzjDkuc

Yapay zeka ve teknoloji gelişmeleri için abone olmayı unutmayın!

Trendyol LLM: https://huggingface.co/Trendyol

Commencis LLM: https://huggingface.co/Commencis/Commencis-LLM

FinLLM'ler: https://arxiv.org/abs/2402.02315

Bölümler

00:00 Giriş

00:22 LLM nedir?

01:15 Ülkemizde LLM

01:24 Trendyol LLM

02:01 Commencis LLM

02:46 Yatırım tavsiyeleri

LLM’ler yani Büyük Dil Modelleri (Large Language Model), genellikle büyük miktarda metin verisi üzerinde eğitilmiş yapay zeka sistemlerini ifade eder. Bu modeller, doğal dil işleme (NLP) görevlerinde ku...

2024-05-1305 min

The MLSecOps PodcastEvaluating RAG and the Future of LLM Security: Insights with LlamaIndexSend us a textIn this episode of the MLSecOps Podcast, host Neal Swaelens, along with co-host Oleksandr Yaremchuk, sit down with special guest Simon Suo, co-founder and CTO of LlamaIndex. Simon shares insights into the development of LlamaIndex, a leading data framework for orchestrating data in large language models (LLMs). Drawing from his background in the self-driving industry, Simon discusses the challenges and considerations of integrating LLMs into various applications, emphasizing the importance of contextualizing LLMs within specific environments.The conversation delves into the evolution of retrieval-augmented generation (RAG) techniques and the future trajectory...

2024-04-2331 min

LLMThe LLM Project: Apple's Vision for AI ToolsExplore Apple's visionary approach to AI-integrated tools through their innovative LLM project, offering a glimpse into the future of technology.

Get on the AI Box Waitlist: https://AIBox.ai/Join our ChatGPT Community: https://www.facebook.com/groups/739308654562189/Follow me on Twitter: https://twitter.com/jaeden_ai

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2024-04-0511 min

Tech FrontierST-LLM: Large Language Models Are Effective Temporal LearnersLarge Language Models (LLMs) have showcased impressive capabilities in text comprehension and generation, prompting research efforts towards video LLMs to facilitate human-AI interaction at the video level. However, how to effectively encode and understand videos in video-based dialogue systems remains to be solved. In this paper, we investigate a straightforward yet unexplored question: Can we feed all spatial-temporal tokens into the LLM, thus delegating the task of video sequence modeling to the LLMs? Surprisingly, this simple approach yields significant improvements in video understanding. Based upon this, we propose ST-LLM, an effective video-LLM baseline with Spatial-Temporal sequence modeling inside LLM...

2024-04-0303 min

The New Stack PodcastLLM Observability: The BreakdownLLM observability focuses on maximizing the utility of larger language models (LLMs) by monitoring key metrics and signals. Alex Williams, Founder and Publisher for The New Stack, and Janikiram MSV, Principal of Janikiram & Associates and an analyst and writer for The New Stack, discusses the emergence of the LLM stack, which encompasses various components like LLMs, vector databases, embedding models, retrieval systems, read anchor models, and more. The objective of LLM observability is to ensure that users can extract desired outcomes effectively from this complex ecosystem.Similar to infrastructure observability in DevOps and SRE practices, LLM observability...

2024-03-2825 min

New Paradigm: AI Research SummariesA Summary of 'LLM Agent Operating System'This is a summary of the AI research paper: LLM Agent Operating System Available at: https://arxiv.org/abs/2403.16971 This summary is AI generated, however the creators of the AI that produces this summary have made every effort to ensure that it is of high quality. As AI systems can be prone to hallucinations we always recommend readers seek out and read the original source material. Our intention is to help listeners save time and stay on top of trends and new discoveries. You can find the introductory section of this recording provided below... This...

2024-03-2613 min

LLMLeading Compliance Transformation: Patronus AI Debuts LLM Evaluation Tool for Regulated SectorsJoin the forefront of compliance transformation with Patronus AI's debut of its LLM evaluation tool designed for regulated sectors. Explore how this innovative solution revolutionizes compliance practices, offering organizations unprecedented efficiency and insight into regulatory compliance.

Get on the AI Box Waitlist: AIBox.aiJoin our ChatGPT Community: Facebook GroupFollow me on Twitter: Jaeden's Twitter

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2024-02-1004 min

MLOps.communityLLM Evaluation with Arize AI's Aparna Dhinakaran // #210Large Language Models have taken the world by storm. But what are the real use cases? What are the challenges in productionizing them? In this event, you will hear from practitioners about how they are dealing with things such as cost optimization, latency requirements, trust of output, and debugging. You will also get the opportunity to join workshops that will teach you how to set up your use cases and skip over all the headaches.Join the AI in Production Conference on February 15 and 22 here: https://home.mlops.community/home/events/ai-in-production-2024-02-15

2024-02-0955 min

LLMShaping the Future: Patronus AI's LLM Evaluation Tool Transforms Compliance in Regulated IndustriesExplore how Patronus AI is shaping the future of compliance management in regulated industries with its innovative LLM Evaluation Tool. Learn how this tool empowers organizations to achieve regulatory compliance with efficiency and precision.

Get on the AI Box Waitlist: AIBox.aiJoin our ChatGPT Community: Facebook GroupFollow me on Twitter: Jaeden's Twitter

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2024-02-0704 min

LLMTech Reshaping: Unveiling the World's Largest Open-Source LLM Dataset - Navigating Language Model AdvancementsJoin the conversation on tech reshaping as the world's largest open-source LLM dataset, featuring 3 trillion tokens, is unveiled, offering insights into navigating advancements in language models. In this episode, explore the potential impact on industry standards, the technological advancements, and the ongoing dialogue between artificial intelligence and the future of language understanding. 🌐💡 #TechReshaping #OpenSourceLLM

Get on the AI Box Waitlist: https://AIBox.ai/

Join our ChatGPT Community: https://www.facebook.com/groups/739308654562189/

Follow me on Twitter: https://twitter.com/jaeden_ai

See Privacy Policy at https://art19.com/privacy and California Pri...

2024-02-0108 min

LLMRevolutionizing Data Security: DynamoFL's $15.1M Funding Transforms LLM Data Leak DefenseJoin the revolution in data security as DynamoFL's $15.1 million funding transforms the landscape of defending against Large Language Model (LLM) data leaks. In this episode, explore the potential impact on safeguarding sensitive information, the technological advancements, and the ongoing dialogue between artificial intelligence and the future of data security. 🔄🔐 #DataSecurityRevolution #DynamoFLDataLeakDefenseTransformation

Get on the AI Box Waitlist: https://AIBox.ai/

Join our ChatGPT Community: https://www.facebook.com/groups/739308654562189/

Follow me on Twitter: https://twitter.com/jaeden_ai

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art...

2024-01-3108 min

LLMGoogle's Bard & LLM PaLM 2 Explored: What's Fresh?Explore the freshness in Google's Bard and LLM PaLM 2, discovering the latest elements reshaping the landscape of AI language models.

Get on the AI Box Waitlist: https://AIBox.ai/

Join our ChatGPT Community: https://www.facebook.com/groups/739308654562189/

Follow me on Twitter: https://twitter.com/jaeden_ai

See Privacy Policy at https://art19.com/privacy and California Privacy Notice at https://art19.com/privacy#do-not-sell-my-info.

2024-01-0715 min

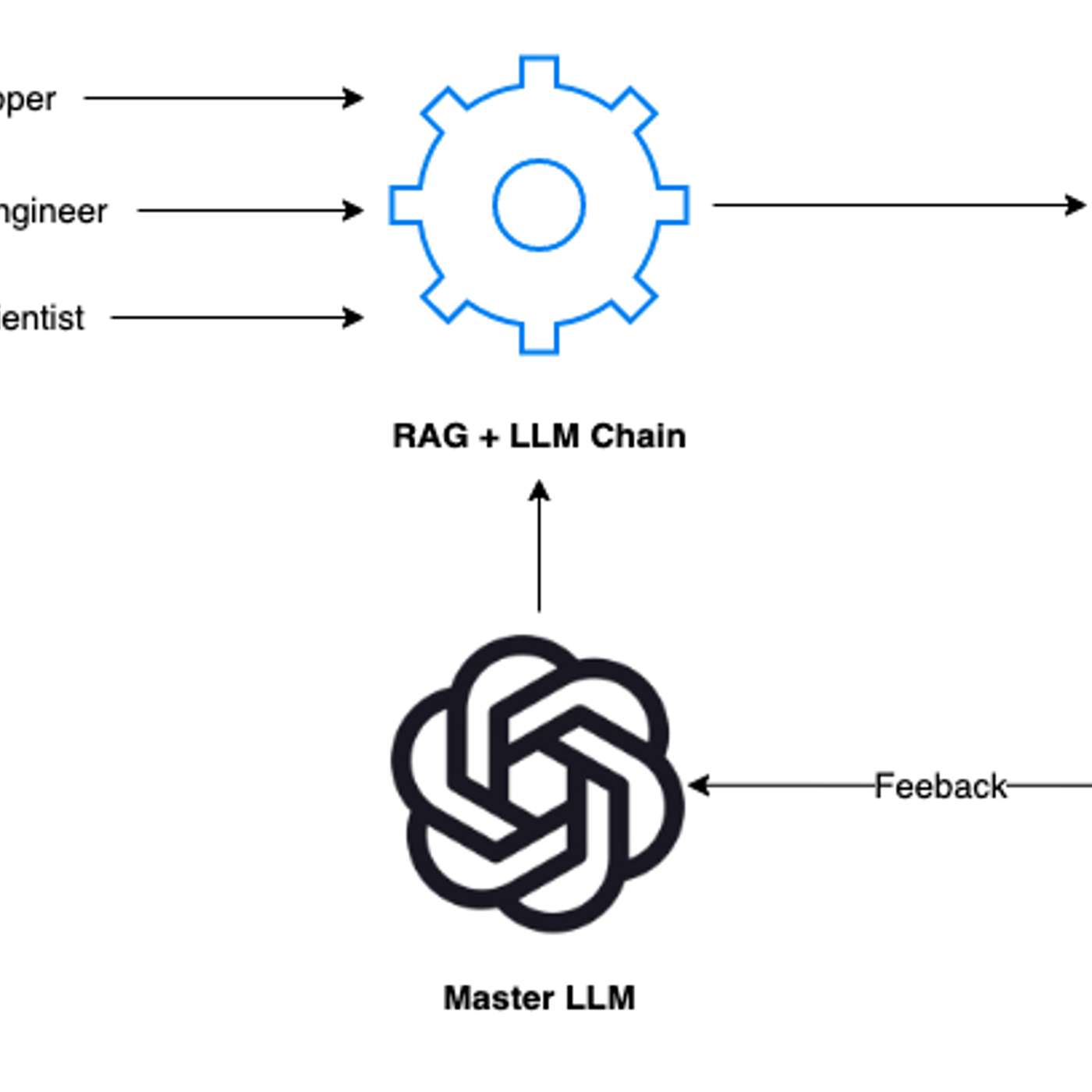

Machine Learning Tech Brief By HackerNoonHow to Effectively Evaluate Your RAG + LLM Applications

This story was originally published on HackerNoon at: https://hackernoon.com/how-to-effectively-evaluate-your-rag-llm-applications.

Ever wondered how some of today's applications seem almost magically smart? A big part of that magic comes from something called RAG and LLM.

Check more stories related to machine-learning at: https://hackernoon.com/c/machine-learning.

You can also check exclusive content about #rag-architecture, #rag-plus-llm-applications, #dual-role-of-master-llm, #llm-cycle-of-improvement, #human-in-loop-feedback, #prompt-tuning-by-master-llm, #automating-evaluation-pipeline, #hackernoon-top-story, and more.

This story was written by: @vndee. Learn more about this writer by checking @vndee's about page,

and for more stories, please visit hackernoon.com.

Ever wondered how some...

2023-12-2813 min